8 Test- und Prüfungsaufgaben

Wir können jeden E-Learning Kurs anhand der Komponenten intendierte Lernziele, Lehr- und Lernmethoden und Prüfungsmethoden beschreiben. In den letzten Kapiteln haben wir diese drei Komponenten anhand der Idee des Constructive Alignment kennen gelernt. Die Kapitel Multimedia Learning, instruktionale Videos und Erklärungen haben die Themen Lehr- und Lernmethoden angesprochen, indem sie uns gezeigt haben, worauf wir in E-Learning Kursen achten müssen, um Lerninhalte zu vermitteln. Lehr- und Lernmethoden umfassen allerdings nicht nur Instruktionen, sondern auch Übungsaufgaben, die den Zweck haben, den Lernstoff während eines Kurses zu festigen. Ebenso geben wir Lernenden in E-Learning Kursen Prüfungsaufgaben, um ihren Kenntnisstand zu diagnostizieren.

In diesem Kapitel werden wir systematisch darlegen, was Übungs- und Prüfungsaufgaben sind und wie sie lernwirksam gestaltet werden können. Zunächst werden wir uns überlegen, welche Funktion Übungs- und Prüfungsaufgaben in E-Learning Kursen haben. Anschließend werden wir beschreiben, wie Übungs- und Prüfungsaufgaben in E-Learning Kursen implementiert werden. Wir werden sehen, dass die Wahl der Übungs- und Prüfungsaufgaben einen Einfluss auf das Lernverhalten von Lernenden hat. Dazu werden wir atomare von holistischen Übungs- und Prüfungsaufgaben unterscheiden. Multiple-Choice Fragen werden wir als atomare Aufgaben bezeichnen und, da sie die häufigste Form der Übungs- und Prüfungsaufgaben sind, genauer beschreiben. Am Ende des Kapitels werden wir uns mit Bewertungsschemas auseinander setzen und zeigen, dass sich Bewertungsschemas eignen, die Idee des Constructive Aligments und des formativen Assessments zu verbinden.

8.1 Übungs- und Prüfungsaufgaben als formatives Assessment

8.1.1 Kriterien lernwirksamer Übungs- und Prüfungsaufgaben

Schau dir einen willkürlichen E-Learning Kurs an und du findest fast immer verschiedene Formen von Übungs- und Prüfungsaufgaben. Im Kurs CS50 von edX beispielsweise lernen Lernende zunächst in instruktionalen Videos wie Computer funktionieren und schreiben anschließend ihre eigene Computerprogramme. Im Kurs Improving Your Study Techniques beantworten Lernende immer wieder Multiple-Choice Fragen, um die Lerninhalte zu festigen. Manchmal entscheiden sich E-Learning Entwickler diese Aufgaben zu prüfen, manchmal dienen diese Aufgaben lediglich der Übung. Nur, warum verwenden wir Übungs- und Prüfungsaufgaben in E-Learning Kursen? Eines ist sicher, wir würden sie nicht verwenden, wenn wir nicht davon ausgehen, dass sie dem Lernen dienen.

Um die Funktion von Übungs- und Prüfungsaufgaben zu verstehen, müssen wir zunächst formatives von summativem Assessment unterscheiden. Der Begriff summatives Assessment ist analog zu dem Begriff Prüfungsaufgaben und bezeichnet alle Aufgaben, die dazu dienen, den Lernstand von Lernenden zu diagnostizieren (Wiliam, 2011). Summatives Assessment dient daher in erster Linie dem Lernen, sondern ermöglicht den Leistungstand von Lernenden zu dokumentieren. Beispielsweise erhalten Lernende am Ende eines E-Learning Kurses ein Zertifikat, welches ihre Leistung in dem Kurs dokumentiert. Wie diese Leistung diagnostiziert wird ist unabhängig von der Methode der Prüfung. Manchmal müssen Lernende nur eine Reihe an Multiple-Choice Fragen beantworten, ein anderes Mal wird von den Lernenden verlangt, dass sie ein umfangreiches Projekt umsetzen.

Im Gegensatz dazu dient formatives Assessment dem Lernen. Formatives Assessment entsteht dann, wenn Lernende gebeten werden, ihr Wissen zu veräußern und sowohl die Lehrenden als auch die Lernenden diese Informationen nutzen, um ihr Verhalten daran anzupassen (Wiliam, 2011). Nehmen wir beispielsweise an, Lernende werden in einem E-Learning Kurs gebeten eine Multiple-Choice Frage zu beantworten. Die Lernenden erhalten Rückmeldung, ob ihre Antwort korrekt ist. Diese Rückmeldung gibt den Lernenden Informationen darüber, ob sie das Prinzip der Frage verstanden haben. Daraufhin können sie sich erneut mit dem Lernmaterial auseinander setzen. Auf der Lehrendenseite könnte das E-Learning System die Antworten aller Lernenden aufzeichnen und den Lehrenden rückmelden, dass nur 10% der Lernenden die Frage richtig beantwortet haben. Als Folge könnten die Lehrenden diese Frage, da sie zu schwierig ist, umschreiben. In beiden Fällen haben die Lernenden als auch die Lehrenden ihr Verhalten auf Grundlage des Kenntnisstands der Lernenden angepasst.

Ein Problem der Unterscheidung zwischen summativem und formativem Assessment ist, dass beide Begriffe nicht trennscharf sind. Black und Wiliam (2009) zeigen, dass auch summatives Assessment, sprich Prüfungsaufgaben, formativ verwendet werden können. Stell dir vor, ein Verbund an Fahrschulen bietet einen Blended-Learning Kurs zum Thema Verkehrsregeln an. Am Ende des Kurses beantworten die Lernenden 20 Multiple-Choice Fragen, die ihr Wissen prüfen. Eine dieser Schule findet heraus, dass ihre Lernende bei den Fragen zu den Vorfahrtsregeln deutlich schlechter abschneiden als die anderen Schulen. Die Lehrenden setzten sich zusammen und überlegen, wie sie den Lernenden die Inhalte zu den Vorfahrtsregeln besser vermitteln können. Nach einem Jahr schauen sie sich die Ergebnisse nochmal an und stellen fest, dass sie zu den anderen Schulen aufgeschlossen haben. In diesem Beispiel wurde zwar ein summatives Assessment durchgeführt, allerdings wurde dieses Assessment formativ genutzt. Die Lehrenden haben die Rückmeldungen der Lernenden genutzt, um ihre Lernumgebung zu verbessern.

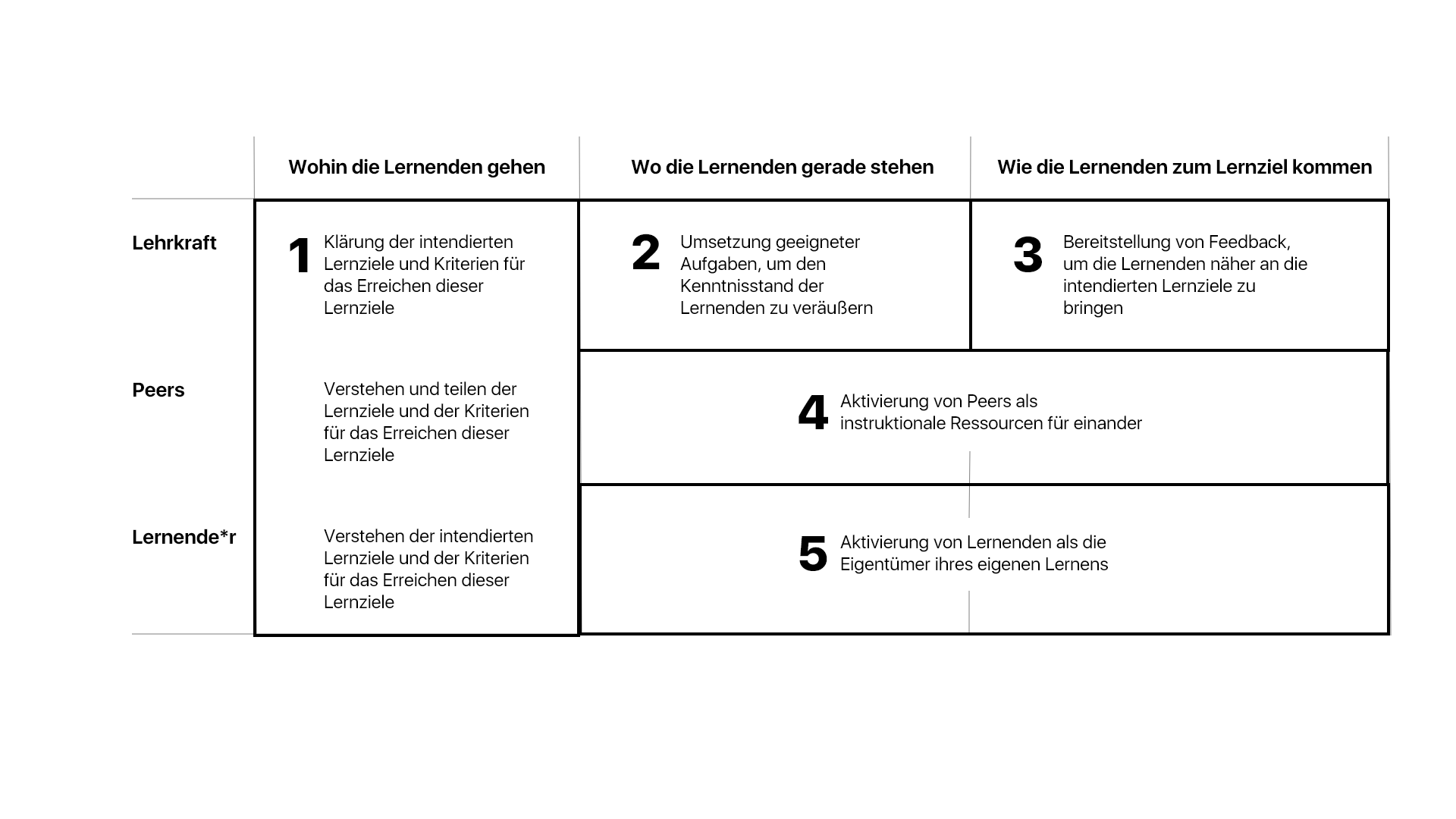

Wenn uns etwas am Lernen liegt, sollten wir uns daher weniger mit der Unterscheidung zwischen summativen und formativen Assessments beschäftigen, sondern uns überlegen, wie Übungs- und Prüfungsaufgaben so eingesetzt werden können, dass sie dem Lernen dienen. Sofern dies unser Anspruch ist, sollten wir genauer verstehen, wie formatives Assessment funktioniert. Black und Wiliam (2009) schlagen fünf Kriterien für lernwirksames formatives Assessment vor. Die Kriterien setzen an drei verschiedenen Fragen (Spalten der nachfolgenden Tabelle) und drei verschiedenen Adressaten an (die drei Reihen der ersten Spalte der nachfolgenden Tabelle). Black und William gehen davon aus, dass formatives Assessment immer drei Fragen ansprechen sollte. Zunächst sollten die Lernenden und die Lernenden zu jeder Zeit wissen, wohin sie gehen. Damit meinen Black und Wiliam, dass Lernende über die intendierten Lernziele informiert sein sollten und ebenso wissen sollten, woran sie erkennen, ob sie diese Lernziele erreicht haben. Die zweite Frage lautet, wo die Lernenden gerade stehen. Lernenden sollte die Möglichkeit gegeben werden, ihren Kenntnisstand zu veräußern. Veräußern bedeutet, dass sie ihr Wissen in einer bestimmten Form schriftlich als auch mündlich festhalten. Im E-Learning können wir dies durch unter anderem durch Rückmeldung auf Grundlage von Multiple-Choice Fragen, Kurzantwortaufgaben, Peer-Assessment, Portfolios oder auch Projekte umgesetzt. Die dritte Frage lautet: Wie können sich Lernende den intendierten Lernziele weiter annähern? Die Antwort dieser Frage geschieht durch Feedback.

Formatives Feedback ist nicht allein die Aufgabe der Lehrenden. In dem Modell von Black und Wiliam (2009) werden sowohl die Peers als auch die Lernenden in den Prozess integriert. Zunächst genügt es nicht, dass die Lehrkräfte, sprich E-Learning Entwickler, die intendierten Lernziele kommunizieren. Die Lernenden müssen diese Lernziele verstehen und genau wissen, woran sie erkennen, ob sie diese Lernziele erreicht haben. Wir haben an verschiedenen Stellen dieses Kurses bereits erkannt, dass Lernende E-Learning Kurse sehr selbstreguliert durchführen und sicher nicht unseren Weg beschreiten. Lernenden in E-Learning Kursen sollte daher die Möglichkeit gegeben werden, selbstreguliert heraus zu finden, wie sie am besten die intendierten Lernziele erreichen. Im Übrigen, diesen Wunsch die intendierten Lernziele zu erreichen, schaffen wir am besten, indem die Lernziele eng mit den Prüfungsmethoden verbunden sind (siehe Constructive Alignment).

Ein weiteres Kriterium für Black und Wiliam ist die Einbindung der Peers in den Feedbackprozess. In E-Learning Kursen mit tausenden Studierenden werden Lehrkräfte nicht in der Lage sein, allen Lernenden Feedback zu geben und von allen Lernenden die Antworten auf die Aufgaben einzusehen. Daher spielen Peers in E-Learning Kursen als Unterstützer des formativen Feedbacks eine große Rolle. Sofern die Peers wissen, welche intendierten Lernziele erreicht werden sollen und woran man erkennt, dass diese Lernziele erreicht sind, sind sie in der Lage, sich Feedback über ihre Leistung zu geben. Viele E-Learning Kurse trainieren Lernende zunächst, wie man Feedback gibt und nutzen anschließend die Peers, um allen Lernenden ausführliches Feedback zu geben. Zuletzt ist formatives Feedback nur möglich, wenn die Lernenden ihr Lernen in die Hand nehmen. Sie müssen sich als Eigentümer ihres Lernens sehen. Im E-Learning kann dies durch unterschiedliche Maßnahmen erreicht werden. In Kursen, für die sich Lernende freiwillig anmelden, ist dieses Kriterium selten ein Problem, da die Lernende bereits ein intrinsisches Interesse daran haben, die Inhalte zu lernen. Schwieriger ist die Umsetzung dieses Kriteriums in E-Learning Kursen, die Lernende durchführen müssen. Solche Kurse werden häufig in der freien Wirtschaft eingesetzt, beispielsweise, wenn Mitarbeiter neue Hygienebestimmungen in einem global arbeiteten Unternehmen lernen sollen. Warum sollten Lernenden den Anreiz haben, Feedback von Lernenden anzunehmen und ihr Lernen daraufhin zu steuern? Eine Möglichkeit bestünde daran, äußere Anreize zu schaffen, indem ein gutes Abschneiden entlohnt wird (z.B., durch eine weitere Weiterbildung, die sich eine Mitarbeiterin aussuchen darf). Ebenso werden Gamification-Elemente eingesetzt, um Lernende zu motivieren, digitale Auszeichnungen zu sammeln beziehungsweise in einer Rangliste unter den Mitarbeitern weiter oben zu stehen (Baptista & Oliveira, 2019).

8.1.2 Umsetzung der fünf Kriterien im E-Learning

Kein E-Learning Kurs wird alle dieser fünf Kriterien umfangreich umsetzen können. E-Learning Produkte werden häufig unter Zeitdruck entwickelt und es mangelt teils an finanziellen Ressourcen, um ein umfangreiches formatives Feedback umzusetzen. Ein weiteres Problem für die Umsetzung des formativen Feedbacks im E-Learning ergibt sich dadurch, dass dieses Modell für den Klassenunterricht entwickelt wurde. Der Klassenunterricht ist in der Regel dynamisch. Lehrkräfte können nach einer Stunde jedes Mal entscheiden, wie sie die nächste Stunde strukturieren werden. Als E-Learning Entwickler haben wir diese Flexibilität nicht. Sobald das E-Learning Produkt konzipiert ist, können wir den Aufbau nicht mehr ändern. Hierdurch sind uns in der Umsetzung des formativen Feedbacks die Hände gebunden. Im E-Learning ist es daher umso wichtiger, dass wir uns bei der Entwicklung eines Produktes umfangreich Gedanken darüber machen, welche Lernziele wir verfolgen, wie wir Lernende durch Instruktionen und Aufgaben unterstützen, diese Ziele zu erreichen, und wie wir Lernende über ihren Leistungsstand durch Feedback informieren.

8.1.2.1 Kommunikation der intendierten Lernziele und der Kriterien für deren erfolgreiche Umsetzung

Jeder E-Learning Kurs kann allerdings ein Mindestmaß dieser Kriterien umsetzen. Das erste Kriterium besagt, dass die Lernenden die intendierten Lernziele kennen und wissen, woran man erkennt, ob diese Ziele erreicht wurden. Bereits dieses Kriterium ist nur sehr selten in E-Learning Kursen umfangreich umgesetzt. Nehmen wir den Kurs Presentation skills: Designing Presentation Slides. Der Kurs ist zwar herausragend bewertet, allerdings kommuniziert er die intendierten Lernziele und die Kriterien für das Erreichen dieser Lernziele nur unzureichend. In Woche eins des Kurses werden folgende Lernziele kommuniziert:

- Learn the key principles of design: focus, contrast, unity

- Understand why “too many text” is not a problem

- Understand what is a “good design”

- Understand the use and misuse of slides

Zunächst sind die Lernziele nicht prüfbar. Ob jemand etwas versteht oder gelernt hat, können wir nicht auf Grundlage der Handlungen der Lernenden erkennen. Das Verb verstehen bedeutet für Lernende sehr Unterschiedliches (Entwistle & Entwistle, 1992). Gerade da das Verb verstehen viel Interpretationsspielraum zulässt, wäre es umso dringlicher, klare Kriterien den Lernenden zu kommunizieren, an denen sie erkennen, ob das Lernziel für sie erreicht wurde. Diese Kriterien finden sich allerdings nicht im Kurs und dadurch ist es für diesen Kurs gar unmöglich formatives Feedback im Modell nach Black und Wiliam (2009) zu geben (schließlich hängen die restlichen Kriterien von dem ersten Kriterium ab).

E-Learning Kurse sollten aus diesem Grund viel Arbeit darin investieren, den Lernenden die Lernziele umfassend und klar zu kommunizieren. Ebenso sollten wir den Lernenden klar machen, woran sie erkennen, ob diese Ziele erreicht wurden. Wir werden später im Kapitel auf Bewertungsschemas eingehen, welche sich dazu eignen, die Leistungsanspruche an die Lernenden zu kommunizieren.

8.1.2.2 Umsetzung geeigneter Aufgaben, um den Kenntnisstand der Lernenden zu veräußern

E-Learning Entwickler sollten zudem Aufgaben entwickeln, die diese Lernziele ansprechen und gleichzeitig den Kenntnisstand der Lernenden veräußern. Dieses Kriterium können wir in E-Learning Kursen nur erfüllen, wenn Lernende hinreichend Aufgaben erhalten, in denen sie gebeten werden, ihr Wissen anzuwenden. Diese Anwendung kann durch Multiple-Choice Fragen, Kurzantworten, Peer-Assessment oder Projekte umgesetzt werden. Entscheidend ist, dass diese Aufgaben mit den Zielen in Verbindung stehen. Erneut zeigt ein Blick auf den Kurs Presentation skills, dass dieses Kriterium nicht immer umgesetzt wird. Nur in vier von insgesamt 17 Elementen in der ersten Woche des Kurses müssen Lernende ihr Wissen veräußern. Ein genauerer Blick zeigt, dass diese Aufgaben nicht immer mit den Zielen in Verbindung stehen. Beispielsweise sollen Lernende eine Powerpoint-Präsentation anhand der gelernten Prinzipien überarbeiten. Diese Aufgabe spricht eher das Verb anwenden als verstehen an und steht damit nicht mit den Lernzielen in Verbindung. Diese beiden Schwächen in dem Kurs sind keine Seltenheit und finden sich in vielen E-Learning Kursen wieder.

E-Learning Entwickler sollten daher darauf achten, dass Lernende genügend Möglichkeiten erhalten, ihr Wissen in irgendeiner Form anzuwenden. Wir haben bereits im Kapitel zu Erklärungen gesehen, dass Follow-Up Aufgaben für die Lernwirksamkeit von Erklärungen wichtig sind. Beispielsweise konnten Koedinger et al. (2015) zeigen, dass Lernende besser in MOOCs abschneiden, je mehr Übungsaufgaben sie beantworteten. Zwar handelt es sich dabei um eine korrelative Studie, aus der man keine Kausalzusammenhänge ableiten kann, allerdings gibt dieses Ergebnis einen ersten Hinweis, dass die Häufigkeit der Übungsaufgaben einen positiven Einfluss auf das Lernen hat. Bestärkt wird dieser Hinweis durch eine Reihe an Untersuchungen, die gezeigt haben, dass der Abruf von Wissen immer eine Lerngelegenheit darstellt (McDaniel et al., 2007; Roediger & Karpicke, 2006). Anders als eine Festplatte, die Informationen lediglich abruft, ändern sich die Gedächtnisspuren bei Menschen, wenn sie ihr Wissen abrufen. Eine theoretische Erklärung hierfür geht auf die New Theory of Disuse von Bjork und Bjork (1992) zurück. In der Theorie gehen Bjork und Bjork davon aus, dass jede Gedächtnisspur zwei Formen der Speicherung hat. Einerseits eine Storage Strength, die angibt, wie stabil die Gedächtnisspur gespeichert ist. Andererseits die Retrieval Strength, die angibt, wie wahrscheinlich die Gedächtnisspur abgerufen werden kann. Während die Storage Strength nicht weniger werden kann, verändert sich die Retrieval Strength abhängig davon, wie lange wir eine Gedächtnisspur nicht mehr abgerufen haben. Jedes Mal, wenn wir Wissen abrufen, stärken sich beide Speicherungen. Wenn wir allerdings für eine lange Zeit, eine Gedächtnisspur nicht mehr abrufen, verringert sich die Retrieval Strength und wir haben keinen Zugang mehr zu der Gedächtnisspur. Aus dieser Theorie kann man erklären, weshalb das Abrufen von Wissen eine Lerngelegenheit darstellt: Der Abruf des Wissens stärkt die Retrieval Strength und sorgt dafür, dass uns zukünftig der weitere Abruf der Gedächtnisspur einfacher fällt. Es ist daher ratsam, Lernende in E-Learning Kursen häufig zu bitten, ihr Wissen abzurufen. Bereits ohne Feedback sind Übungsaufgaben eine Lerngelegenheit.

Ebenso sollten wir darauf achten, dass die Aufgaben mit den Lernzielen in Verbindung stehen. Die Idee des zweiten Kriteriums von Black und Wiliam (2009) ist, dass Lehrende und Peers die Information zu den Ergebnissen der Übungsaufgaben nutzen können, um damit den Lernenden zu helfen, näher an das intendierte Lernziel zu kommen. Aufgaben, die nicht mit den Lernzielen in Verbindung stehen, machen diese Funktion unmöglich, da die Informationen aus den Aufgaben nicht genutzt werden können, um Lernende näher zu den intendierten Lernzielen zu bringen. Stell dir erneut den Präsentationskurs von gerade eben vor. Welche Informationen über das Verständnis von Designprinzipien erhalten wir von den Lernenden, wenn diese eine PowerPoint überarbeiten? Es könnte sein, dass die Lernenden mechanisch eine Abfolge wiederholen, die zwar dazu führt, dass die Präsentation gut gestaltet ist, allerdings keine Auskunft darüber gibt, ob die Lernenden erklären können, was gutes Design auszeichnet. Genauso gut helfen uns keine Multiple-Choice Fragen weiter, die nachschlagbares Wissen aus vorherigen Videos prüfen. Solange diese Aufgaben nicht mit den Zielen in Verbindung stehen, gibt uns deren Antwort keine Information darüber, wie wir Lernende unterstützen können, die Ziele zu erreichen.

8.1.2.3 Bereitstellung von Feedback

Das Modell von Black und Wiliam (2009) besagt als nächstes, dass wir den Lehrenden Feedback über ihre Antworten auf die Aufgaben geben sollten. Eine Reihe an Forschung zeigt, dass Feedback Lernenden wirksam hilft, Konzepte und Prinzipien besser zu verstehen (Hattie & Timperley, 2007; van der Kleij, 2015). Feedback ist allerdings nicht gleich Feedback. Der Zweck von Feedback ist die Diskrepanz zwischen einem aktuellen Leistungsstand und einem gezieltem Leistungsstand zu verringern (siehe Hattie & Timperley, 2007). Dies können wir unterschiedlich umsetzen. Eine einfache Multiple-Choice Aufgabe mit der Rückmeldung ob eine Antwort richtig oder falsch ist, hilft Lernenden nicht umfassend die Diskrepanz zu schließen. Lernende müssen sich fragen, wie sie auf Grundlage dieser Information ihr Lernen steuern können, um die Diskrepanz zu schließen. Die Meta-Analyse von van der Kleij et al. unterstreicht diese Annahme, indem sie zeigt, dass elaboriertes Feedback, bei dem Lernenden eine Erklärung für ihre Antwort erhalten, wirksamer ist als Feedback, welches lediglich angibt, ob eine Antwort richtig oder falsch ist. Ebenso zeigt die Meta-Analyse, dass Feedback in E-Learning Kursen wirksamer ist, wenn es zeitnah gegeben wird. Shute (2008) betont allerdings, dass zeitnahes Feedback insbesondere wichtig ist, wenn die Lernenden die jeweilige Aufgabe als schwierig empfinden. Die Bereitstellung von zeitnahem Feedback ist eines der wichtigsten Vorteile von E-Learning Produkten im Gegensatz zu Kursen der Präsenzlehre. Einfache Aufgaben wie Multiple-Choice Fragen können direkt beantwortet werden, indem Nutzer einen Button klicken. Ebenso können komplexere Projekte schnell bewertet werden, indem eine digitale Infrastruktur geschaffen wird, die es ermöglicht Mentoren direkt zu benachrichtigen, sobald ein Projekt bewertet werden soll (Udacity setzt diese Idee mit seinen Nanodegrees um).

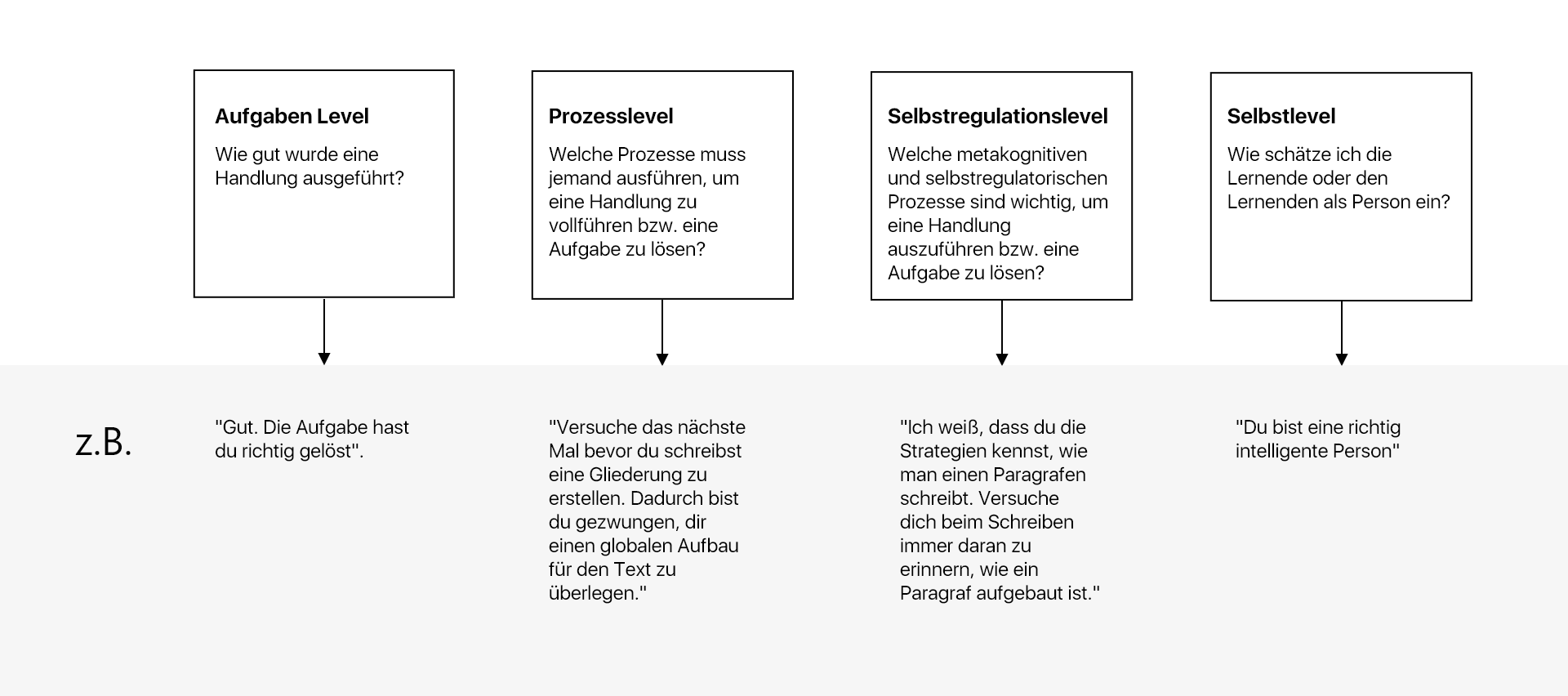

Auf Grundlage ihrer umfassenden Literaturrecherche empfiehlt Shute ebenso, dass sich Feedback auf die Aufgabe und nicht auf die Lernenden richten sollte. Was heißt das? Eine Antwort auf diese Frage erhalten wir, wenn wir uns das Feedbackmodell von Hattie und Timperley (2007) ansehen. Die Autoren beschreiben vier Level, auf die sich Feedback richten kann.

Feedback auf dem Level der Aufgabe gibt Lernenden Informationen darüber, ob sie eine Handlung oder eine Aufgabe richtig oder falsch ausgeführt haben. Diese Form des Feedbacks findet sich am häufigsten in E-Learning Kursen, indem Lernende Feedback darüber erhalten, ob ihre Antwort in einer Multiple-Choice Frage richtig oder falsch war. Feedback auf der Ebene der Aufgabe kann zudem durch Hinweise angereichert werden, was Lernende fehlt, um eine Aufgabe korrekt zu beantworten: „Du musst das Ergebnis als Bruch und nicht als Kommazahl angeben".

Feedback auf der Ebene des Prozesses beschreibt, wie Lernenden ihre Handlungen und Schritte in den Aufgaben anpassen können, um zu einem zufriedenstellenden Ergebnis zu kommen. Dieses Prinzip kennt jeder aus dem Sport. Tennistrainer sagen zum Beispiel: „Versuche beim nächsten Mal den Schläger beim Schlag flach zu halten" oder „Versuche beim Schlag den Schläger durchzuziehen und nicht zu stoppen, sobald du den Ball berührt hast". Während man beim Feedback auf der Ebene der Aufgabe sagen würde, dass ein Spieler den Ball über das Feld geschlagen hat und der Ball im Feld landen sollte, beziehen sich die beiden Beispiele auf den Prozess, um zu dem Ziel zu gelangen. Feedback auf der Ebene des Prozesses findet sich in E-Learning Umgebungen lediglich in umfangreichen Aufgaben, bei denen Lernende ihr Wissen anwenden müssen. Beispielsweise in Projekten, in denen Lernende eine Webseite schreiben sollen oder in Projekten, in denen Lernende eine durchgeführte Moderation hochladen sollen, welche später bewertet wird. Technisch ist Feedback auf der Ebene des Prozesses nur in algorithmischen Disziplinen umsetzbar. Für alle andere Disziplinen kann dieses Feedback nur umgesetzt werden, wenn Lehrkräfte und Peers sich die Antworten und Handlungen der Lernenden anschauen (siehe Kriterium 2 nach Black & Wiliam, 2009).

Feedback auf der Ebene der Selbstregulation findet statt, wenn Lernende ermutigt werden, über ihre Fähigkeiten und ihre Selbstregulation nachzudenken: „Du weißt, wie man dieses Problem löst. Was war der Trick, dieses Problem zu lösen?“, „Was haben wir letzte Woche besprochen als du dieses Problem hattest?”. Solches Feedback erfüllt ebenso das fünfte Kriterium nach Black und William (2009), da es die Lernenden in die Pflicht nimmt, Eigentümer ihres eigenen Lernens zu sein. Erneut findet solches Feedback selten in E-Learning Kursen statt. Es benötigt eine hinreichende Beziehung zwischen den Lehrenden und den Lernenden, um Feedback auf der Ebene der Selbstregulation zu geben. Am ehesten lässt sich Feedback auf der Ebene der Selbstregulation durch Online-Mentorenprogramme umsetzen, in denen Mentoren die Lernenden über einen längeren Zeitraum begleiten.

Feedback auf der Ebene des Selbst, bezieht sich auf die Person und nicht auf die Handlungen einer Person: „Du bist ein toller Kerl“, „Bist ein Käpsele”, „Richtig stark!". Solches Feedback findet sich häufig in E-Learning Kursen in der Form von standardisierten Rückmeldungen von kurzen Übungen (z.B. Multiple-Choice Fragen). Feedback auf der Ebene des Selbst gibt Lernenden keine Informationen darüber, wie sie ihr Lernen verändert können. Hattie und Timperley (2007) zeigen in ihrem Review, dass verschiedene Meta-Analysen zum dem Schluss kommen, dass Feedback auf der Ebene des Selbst wenig lernförderlich ist. Es ist daher nicht zu erwarten, dass Lob als Mittel zur Förderung des Lernens in E-Learning Kursen hilfreich ist. Kritiker würden sagen, dass Lob allerdings motivierend wirkt. Allerdings zeigt die Motivationsforschung, dass die Motivation für einen Lerngegenstand maßgeblich davon abhängt, wie groß unsere Überzeugung ist, eine bestimmte Handlung ausführen zu können (Linnenbrink & Pintrich, 2013). E-Learning Entwickler sollten daher anstatt übermäßig Lob zu verteilen, darauf achten, dass Lernende durch viele Übungen die Überzeugung entwickeln, dass sie Kompetenz in einem Themengebiet aufbauen.

8.1.2.4 Aktivierung von Peers als instruktionale Ressourcen für einander

E-Learning Kurse werden oft genutzt, da sehr viele Lernende unterrichtet werden müssen. Beispielsweise in Unternehmen, deren Mitarbeiter über ein Land oder gar den Globus verteilt sind. Ebenso nehmen in MOOCs häufig tausende Lernende teil. Die Vielzahl der Lernenden in diesen Kursen stellt Entwickler vor das Problem, wie Lernende Feedback auf komplexere Aufgaben, wie beispielsweise Projekte erhalten können. Keine Lehrkraft kann tausende Projekte bewerten. Eine Möglichkeit ist daher häufig die Verwendung der Peers. Nehmen wir an, ein Kurs hat 1000 Lernende und diese Lernende müssen für eine Aufgabe ein kurzes Essay schreiben. Wenn jede Lernende ein Essay eines anderen Lernenden bewertet, ist es ohne großen Mehraufwand möglich, Feedback über ihre Abgaben zu erhalten. Coursera beispielsweise hat einen umfassendes Tool in ihrer Plattform implementiert, mit denen Peers sich gegenseitig Rückmeldung über ihre Aufgaben geben können. Weitere Plattformen wie beispielsweise Rhyme werden E-Learning Anbietern zukünftig ermöglichen, nicht nur das Produkt einer Aufgabe einsehen zu können, sondern Lernende während dem Lösen einer Aufgabe zu begleiten. Hierdurch können Peers eingesetzt werden, um Lernenden zum Beispiel Feedback auf ihren Prozess zu geben.

8.1.2.5 Aktivierung von Lernenden als die Eigentümer ihres eigenen Lernens

Das letzte Kriterium von Black und Wiliam (2009) besagt, dass Lerner in die Verantwortung genommen werden sollten, ihr Lernen zu steuern. Wie können wir dieses Kriterium in E-Learning Kursen umsetzen? Am einfachsten, indem wir es ansprechen. Alle großen E-Learning Anbieter haben mindestens einen Blogartikel, in denen sie Lernenden erklären, wie diese am besten selbstständig in den Kursen lernen können (z.B. Udacity, edX, Coursera). Ungeachtet dessen ist dieses Kriterium bereits in vielen E-Learning Kursen bereits erfüllt, da Lernende selbst entscheiden, dass sie bestimmte Kurse besuchen möchten. Sie haben daher ein eigenes Interesse, den Kurs abzuschließen. Am stärksten steuern wir allerdings die Lerner dorthin, Eigentümer ihres Lernens zu sein, indem wir die Übungs- und Prüfungsaufgaben holistisch gestalten, indem wir Lernende nicht Kurzaufgaben (atomistische Aufgaben) lösen lassen, die innerhalb von Minuten zu lösen sind, sondern ihnen Aufgaben geben, die sie zwingen, eigenständig Lösungen für die Aufgaben zu erhalten.

8.1.3 Übungs- und Testaufgaben aus der Sicht des Constructive Alignment und von Feedbackmodellen

Verbinden wir die Idee des Constructive Alignment mit dem Feedbackmodell von Black und Wiliam (2009) und von Hattie und Timperley (2007) erhalten wir ein umfassendes Gerüst, anhand dessen wir lernförderliche Kurse umsetzen können. Einer der zentralen Idee des Constructive Alignment ist, dass die Prüfungsform für Lernende handlungsleitend ist. Sobald wir Lernziele haben, müssen wir diese aufgrund dieser Perspektive der Lernenden mit dem Prüfungsmethoden verbinden. Die Feedbackmodelle von Black und Wiliam und von Hattie und Timperley zeigen uns, wie wir uns diese Perspektive für Feedback zu nutzen machen können. Einerseits zeigt uns das Modell, das Feedback nur funktionieren kann, wenn die Lernenden wissen, wohin wir mit ihnen gehen wollen. Wir haben an verschiedenen Stellen gesehen, dass Lernende opportunistisch sind und sehr selbstreguliert entscheiden, welche Lerninhalte sie sich ansehen. Eine klare Kommunikation der Erwartungen vereinfacht die Selbstregulation der Lernenden, in dem wir ihnen zeigen, worauf wir bei der Prüfung ihres Lernens achten werden. Zudem zwingt uns das Modell von Black und Wiliam Übungs- und Prüfungsaufgaben zu verwenden, um den Lernenden Feedback über ihr Lernen zu geben. Der Zweck der Übungs- und Prüfungsaufgaben ist in dieser Idee nicht die Diagnose des Wissens, sondern die Veräußerung des Wissens, damit wir den Lernenden Feedback geben können. Zuletzt zeigt uns das Modell, dass Lehrende nicht die einzigen Menschen sind, die sich am formativen Assessment beteiligen. Peers spielen in dem Modell eine ebenso wichtige Rolle, da auch sie Feedback geben können. Ebenso macht das Modell deutlich, dass formatives Feedback nur funktioniert, wenn die Lernenden das Feedback nutzen, um ihr Lernen voran zu treiben.

8.2 Atomistischer und holistische Aufgaben

Übungs- und Prüfungsaufgaben als Lernmethode gelingen auf dem Hintergrund der eben beschriebenen Modelle am besten, sobald die einzelnen Kriterien dieser Modelle umgesetzt werden. Die Frage für E-Learning Entwickler ist, wie dies didaktisch umgesetzt werden kann. Um diese Frage zu beantworten, werden wir fortan atomistische von holistischen Übungs- und Prüfungsaufgaben unterscheiden.

8.2.1 Atomistische Aufgaben

Atomistisch bedeutet laut dem Duden so viel wie „in einzelne Einzelbestandteil auflösend“. Wenn wir von atomistischen Aufgaben sprechen, meinen wir damit Aufgaben die lediglich einzelne Bestandteile eines Lernziels ansprechen. Beispielsweise sind Multiple-Choice Aufgaben atomistisch, da sie nur einzelne Aspekte eines größeren Prinzips abfragen. Stell dir folgende Frage vor:”Welches der folgenden Prinzipien ist eines der drei zentralen Prinzipien guten Designs? (a) Einfachheit, (b) Fokus, (c) Saturiertheit oder (d) Klarheit". Diese Frage ist atomistisch, da das komplexe Problem guten Designs auf ein Bestandteil herunter gebrochen wurde. Für die Beantwortung der Frage müssen nicht alle Kriterien guten Designs aufgezählt oder erklärt werden, sondern es genügt eines der wichtigen Kriterien zu benennen. Weitere Beispiele für atomistisch Aufgaben sind Single-Choice Aufgaben oder Kurzantworten.

8.2.2 Holistische Aufgaben

Holistisch bedeutet so viel wie „ganzheitlich". Bei einer holistischen Aufgabe bitte ich Lernende darum, eine Frage in ihrer Komplexität zu beantworten. Beispielsweise, indem ich Lernende bitte ein Projekt umzusetzen, ein Portfolio anzufertigen oder einen Text zu schreiben. Holistische Aufgaben sind in der Regel mit einem größeren Aufwand verbunden und verlangen daher mehr Zeit als atomistische Aufgaben. Formatives Feedback wie wir es eben beschrieben haben, gelingt am ehesten mit holistischen Aufgaben, da sie mehrere Bedingungen des Modells von Black und Wiliam erfüllen: (1) Sie erlauben es den Kenntnisstand der Lernenden umfassend zu veräußern, indem Lernende gezwungen werden ihr Wissen den Lehrenden und den Peers zu kommunizieren. (2) Durch diese Veräußerung des Wissens ermöglichen Sie Lehrenden und Peers Feedback auf den Kenntnisstand der Lernenden zu geben. (3) Durch die Komplexität der Aufgabe ermöglichen Sie Lehrenden die Erwartungshaltung und die Ziele des Kurses klarer zu kommunizieren. Holistische Aufgaben erlauben Lehrenden beispielsweise ein umfangreiches Bewertungsschema zu erstellen, anhand dessen den Lernenden kommuniziert werden kann, was eine gute von einer schlechten Abgabe unterscheidet.

Eine der wichtigsten Funktionen von holistischen Aufgaben ist die Vermittlung komplexer Fertigkeiten (van Merriënboer & Kester, 2008) Stell dir beispielsweise vor, angehende Chirurgen müssen lernen, eine Blinddarmoperation durchzuführen, oder angehende Piloten müssen lernen, wie man ein Flugzeug fliegt. Um diese komplexen Fertigkeiten zu lernen, könnten man lediglich atomistische Übungs- und Prüfungsaufgaben verwenden. Lernende würden hierdurch beispielsweise lernen, an welcher Stelle der Motor in einem Flugzeug angeschaltet wird, beziehungsweise, an welcher Stelle der Körper des Patienten aufgeschnitten werden sollte. Sprich, Lernende lernen anhand von atomistischen Aufgaben die einzelnen Bestandteile der komplexen Fertigkeiten. Was sie allerdings nicht lernen, ist die Beziehung dieser Bestandteile. Welches der folgenden Szenarien wäre dir am liebsten? Möchtest du von einem Chirurg operiert werden, der umfangreiche technische Fähigkeiten besitzt, allerdings wenig Ahnung vom menschlichen Körper hat? Oder würdest du lieber von einem Chirurg operiert werden, der ein umfangreiches Wissen über den menschlichen Körper, allerdings zwei linke Hände hat? Oder würdest du gerne von einem Chirurg operiert werden, der umfangreiche technische Fertigkeiten, allerdings eine abwertende Haltung zu seinen Patienten hat? Du würdest dich vermutlich von keinem dieser Chirurgen operieren lassen. Warum? Weil sie die komplexe Handlung des Operierens nicht ausführen können. Ihn mangelt es an einzelnen wichtigen Fertigkeiten, die notwendig sind, um erfolgreich zu operieren.

Holistische Aufgaben lösen daher drei Probleme (van Merriënboer & Kester, 2008): Einerseits führen sie dazu, dass das Wissen nicht fragmentiert gespeichert wird. Lernende lernen, in welchem Zusammenhang die einzelnen Wissensbausteine stehen. Zudem lernen sie den Prozess einer Fertigkeit (z.B. „Erst die Kupplung drücken, dann das Gas kommen lassen"). Zweitens führen holistische Aufgaben dazu, dass das neu zu erwerbende Wissen mit dem bestehenden Wissen der Lernenden verbunden wird. Beispielsweise gelingt die Integration, indem die holistische Aufgabe die Lernenden zwingt bestehende Verhaltensweisen mit der zu erlernenden Fertigkeit zu verbinden. Zum Beispiel könnte eine Simulation einer Blinddarmoperation Lernenden helfen, das Wissen um die Sektion eines Tieres mit dem Aufschneiden des menschlichen Körpers zu verbinden. Drittens fördern holistische Aufgaben den Transfer des Wissens. Lernenden sind häufig nicht in der Lage, das Wissen aus E-Learning Kursen in die Praxis zu übertragen. Holistische Aufgaben sind per Definition so definiert, dass die Lernenden gezwungen werden, die Fertigkeiten Stück für Stück in ihrer Praxis anzuwenden.

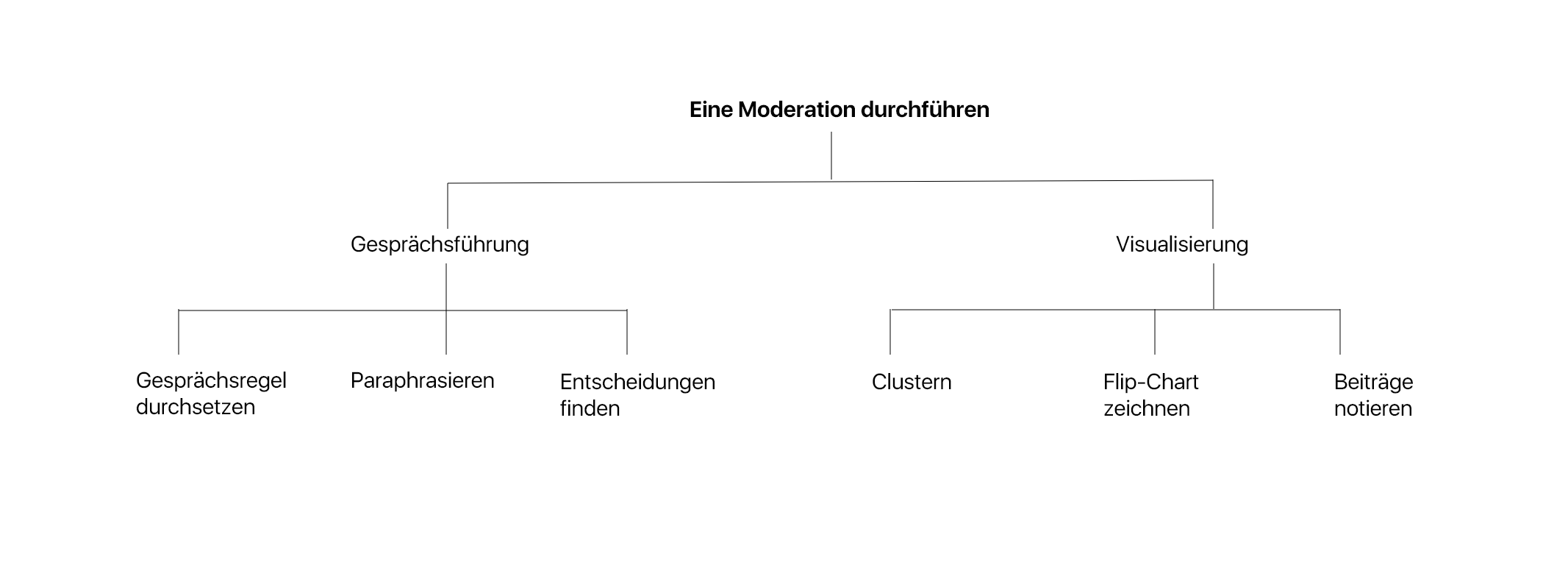

Sowohl in E-Learning Kursen, in denen vorwiegend atomistische Aufgaben eingesetzt werden als auch in E-Learning Kursen, in denen holistische Aufgaben eingesetzt werden, sollten mehrere Aufgaben verwendet werden (van Merriënboer et al., 2002). Für holistische Aufgaben gilt, dass diese sowohl von einfach nach komplex als auch variable gestaltet werden sollten. Die Strukturierung vom Einfachen zum Komplexen findet sich ganz häufig in motorischen Aufgaben. Ein Sportlehrer, welcher seinen Schülern zeigt, wie ein Handstand funktioniert, wird in der Regel den Schülern zuerst vormachen, wie ein Handstand umgesetzt wird. Im Anschluss unterstützt die Lehrperson die Schüler, indem er oder sie die Schüler bittet, den Handstand an der Wand zu machen. Mit einer ähnlichen Progression vom Einfachen zum Schweren sollten holistische Aufgaben im E-Learning eingesetzt werden. In einem E-Learning Kurs über Moderationstechniken könnten Lernende beispielsweise zunächst eine Moderation beobachten. Im Anschluss sollen sie eine Moderation durchführen, hochladen und online diskutieren, bei der sie nur auf die Fragetechniken achten sollen. Zum Schluss sollen sie eine Moderation aus der Praxis durchführen, hochladen und online diskutieren. Neben der Progression vom Einfachen zum Schweren sollten die holistische Aufgaben variabel gestaltet sein. Variabel bedeutet, dass Lernende sich bei den Aufgaben auf unterschiedliche Aspekte der Fertigkeit konzentrieren sollten (Björk & Björk, 2011). Bei unserem Beispiel der Moderationstechniken könnten Lernenden unter anderem eine Moderation durchführen, in der sie die Fragetechniken üben, das Notieren der Beiträge üben oder die Lösung eines Konfliktes zwischen den Parteien lösen. In jeder Aufgabe beschäftigen sich die Lernenden mit der komplexen Tätigkeit, müssen allerdings auf unterschiedliche Aspekte der Tätigkeit achten.

Konkret könnten diese beiden Aspekte in einem E-Learning Kurs dadurch umgesetzt werden, dass Lernende mehrere holistische Aufgaben zu einer komplexen Fertigkeit erhalten und sich diese Aufgaben anhand ihrer Komplexität und Variabilität unterscheiden. Nehmen wir Moderieren als komplexe Tätigkeit (siehe nächste Abbildung). Um Lernenden in einem E-Learning Kurs die Fertigkeit des Moderierens zu vermitteln, könnten Lehrende die Lernenden bitten, sechs Moderationen durchzuführen. Drei der Moderationen befassen sich mit der Gesprächsführung und zwei mit dem Thema der Visualisierung:

Für jede dieser zwei Themen gibt es drei Aufgaben. Beispielsweise sollen die Lernenden für eine Aufgabe üben, Gesprächsregeln durchzusetzen. Hierzu werden die Lernenden zunächst über diese Gesprächsregeln instruiert und versuchen selbst in ihrem Bekanntenkreis eine Moderation durchzuführen. Dabei sollen sie darauf achten, dass die Gesprächsregeln eingehalten werden. Das Video dieser Moderation laden die Lernenden auf die Lernplattform hoch, in welcher sie anschließend Feedback über ihre Moderation erhalten. Ganz ähnlich werden die anderen Aufgaben umgesetzt. Zu Beginn des Kurses könnte die Lehrperson an ein oder zwei Beispielen eine Moderation vor den Lernenden vormachen. Zuletzt könnten die Lernenden als Meisterstück eine Moderation durchführen und auf alle Aspekte der Moderation achten.

Andere Beispiele für einen holistischen Ansatzes findet sich in verschiedenen E-Learning Kursen. Im Kurs Mobile Application Experiences führen Lernende mehrere holistische Aufgaben durch, in denen sie die einzelnen Schritte der Entwicklung einer App lernen. In dem Textbuch The Elements of Computing Systems bauen Lernenden durch holistische Aufgaben einen Computer aus einzelnen Bestandteilen zusammen. Das Textbuch ist eine Form des E-Learning, da die Lernenden den Computer digital und nicht physisch durch eine Software bauen. Coursera verwendet holistische Aufgaben, indem Lernende sogenannte Capstone Courses durchführen, in denen sie ein komplexes Produkt erstellen.

Am Ende des Kapitels werden wir verstehen, wie wir holistische Aufgaben als formatives Assessment verwenden können. Hierzu werden wir uns mit der Rolle der Bewertungsschemas auseinander setzen. Vorher müssen wir allerdings verstehen, wie atomistische und holistische Aufgaben im E-Learning eingesetzt werden und welchen Einfluss die Wahl der Aufgaben auf das Lernverhalten der Lernenden hat. Zuletzt werden wir uns Multiple-Choice Aufgaben als Prototyp der atomistischen Aufgaben genauer ansehen und auf Bewertungsschemas von holistischen Aufgaben zu sprechen kommen.

8.3 Atomistischer und holistischer Ansatz im E-Learning

Es gibt in der Regel vier verschiede Ansätze, wie Übungs- und Prüfungsaufgaben in E-Learning Kursen implementiert werden. Wir nennen diese Ansätze den minimalistischen, den atomistischen, den holistischen und den gemischten Ansatz.

8.3.1 Der minimalistische Ansatz

Im minimalistischen Ansatz eines E-Learning Kurumfes hat keine Übungs- und Prüfungsaufgaben bzw. kein Assessment. In dem Ansatz gibt es lediglich verschiedene Formen der Instruktion (z.B. Videos und Texte), allerdings keine Übungs- und Prüfungsaufgaben, die für formatives Assessment verwendet werden können. Meist sind die Lerninhalte nach Themen und nach Wochen geordnet. Die Playlist Grundlagen der Analysis von 3Blue1Brown auf YouTube beispielsweise verfolgt einen minimalistischen Ansatz. Lernende sehen in dieser Playlist lediglich instruktionale Videos ohne aufgefordert zu werden, ihr Lernen durch Übungs- und Prüfungsaufgaben zu festigen. Der Kurs Javascript30 von Wes Bos ist ebenso vorwiegend minimalistisch umgesetzt, da Lernende fast ausschließlich instruktionale Videos erhalten.

Der minimalistische Ansatz verfolgt die Idee des Lernens als Wissensaufnahme (in anderen Worten: information acquisition, siehe Mayer, 2019). Allerdings ist der minimalistische Ansatz didaktisch schwach, da Lernende darin unterstützt werden die Lerninhalte passiv aufzunehmen (Salomon, 1984). Indem Lernende zudem keine Rückmeldung über ihren Kenntnisstand erhalten, haben sie weniger Möglichkeiten, ihr Lernen auf Grundlage dieser Rückmeldungen zu steuern und überschätzen ihren tatsächlichen Kenntnisstand potentiell (Dunning et al., 2003). Ein weiterer Nachteil ist, dass der minimalistische Ansatz kein formatives Feedback ermöglicht, da Lernende ihr Wissen nicht veräußern müssen. E-Learning Entwickler sollten daher auf den minimalistischen Ansatz weitgehend verzichten, wenn Nutzer aus dem E-Learning Kurs vordergründig etwas lernen sollen.

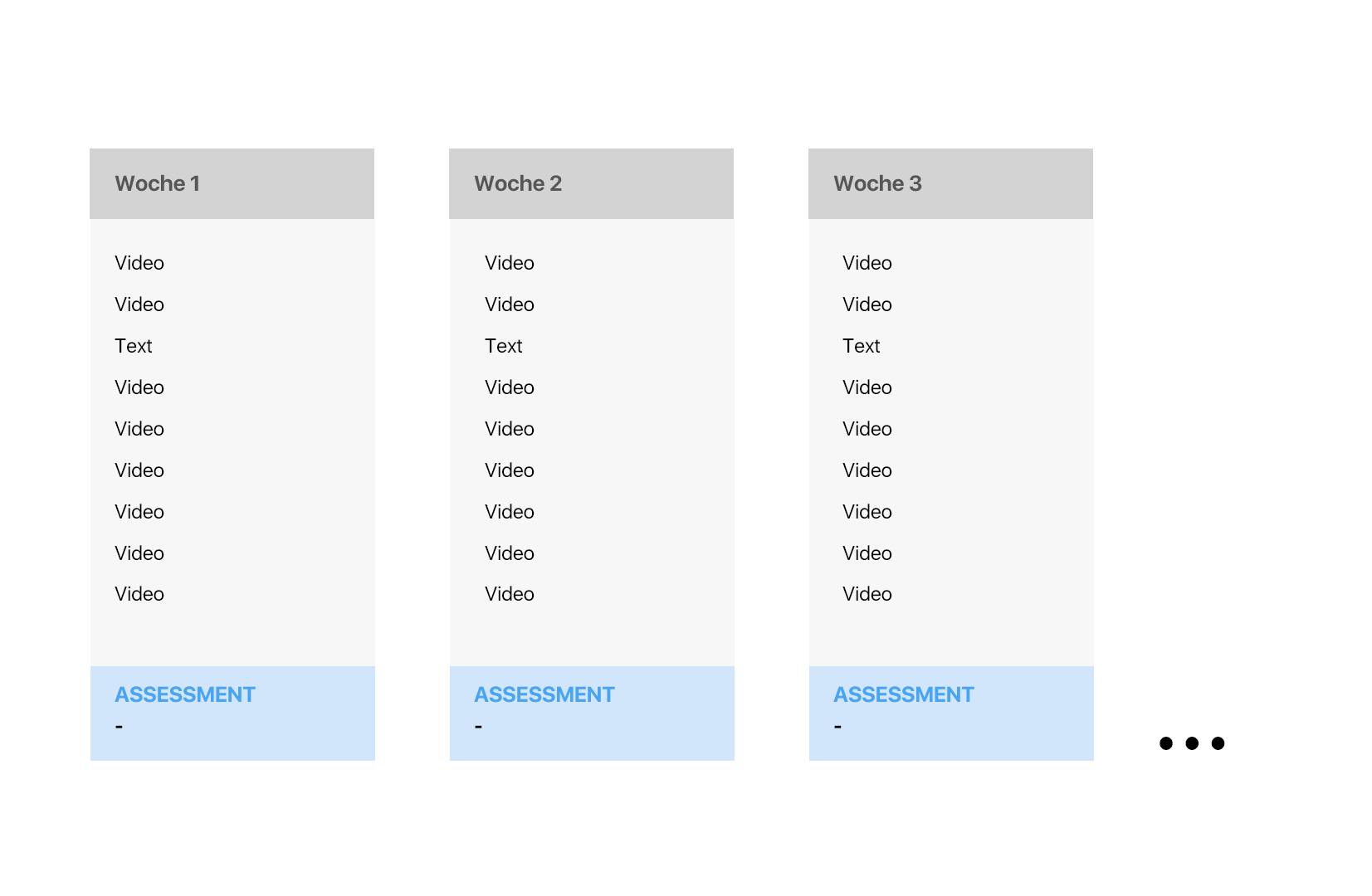

8.3.2 Der atomistische Ansatz

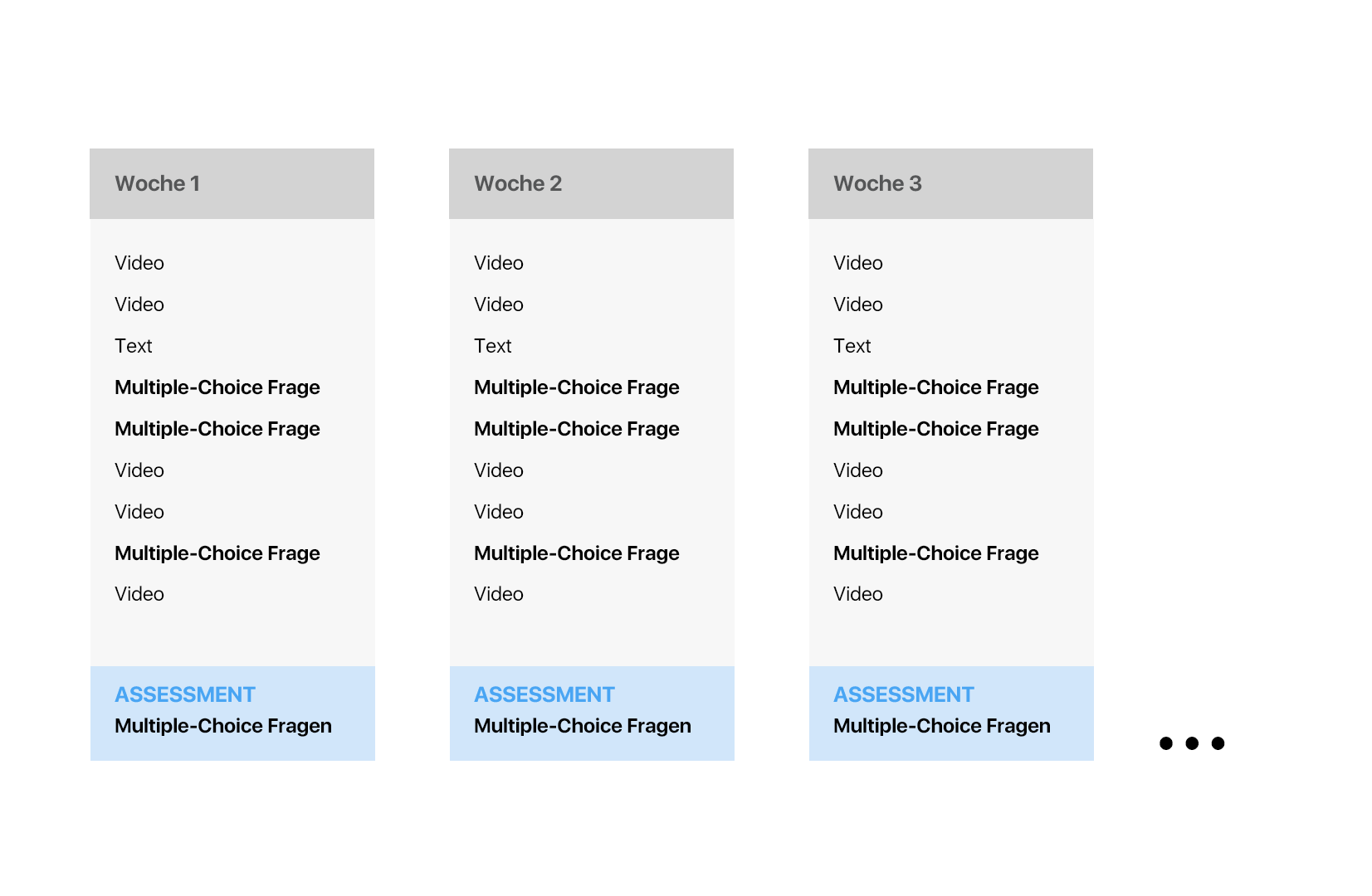

Der atomistische Ansatz zeichnet sich dadurch aus, dass Formen der Instruktion mit atomistischen Aufgaben angereichert werden. Den atomistischen Ansatz erkennt man daran, dass ein Thema in einem E-Learning Kurs in verschiedene Module bzw. Wochen aufgeteilt wird und es innerhalb der Module für jedes Unterthema ein Assessment am Ende des Moduls gibt. Zusätzlich finden sich einzelne atomistische Aufgaben innerhalb des Moduls. Ein beispielhaftes Schema dieses Ansatzes ist im folgenden Bild dargestellt:

Beispiel eines atomistische Ansatzes

Der atomistische Ansatz ist eines der häufigsten Ansätze in E-Learning Kursen. Einerseits, da er nicht so viel Aufwand erfordert wie der holistische Ansatz, den wir gleich kennen lernen werden, andererseits, da er technisch leicht zu realisieren ist. Multiple-Choice Aufgaben gibt es beispielsweise in jeder E-Learning Plattform in der Regel. Im atomistischen Ansatz finden sich zudem keine holistischen Aufgaben, in denen Lernende die die einzelnen Komponenten der atomistischen Aufgaben verbinden müssen. Das bedeutet, es gibt keine Projekte, Portfolios, umfassende Diskussionen oder Schreibaufgaben in E-Learning Kursen, die einem atomistischen Ansatz folgen. Unter anderem folgt der Kurs Think Again I: How to Understand Arguments von Coursera oder der Kurs Quantum Mechanics for Everyone von edX diesem Ansatz.

Didaktisch ist der atomistische Ansatz sinnvoll, wenn es E-Learning Entwicklern um die Vermittlung einzelner Fakten geht. Steht der Transfer im Vordergrund, ist der atomistische Ansatz nicht sonderlich lernförderlich, da Lernende nicht darin unterstützt werden, komplexe Handlungen zu lernen beziehungsweise durch eine fehlende Variabilität in den Aufgaben, keine Möglichkeit erhalten, ihr Wissen unter verschiedenen Kontexten anzuwenden. Zudem kann der atomistische Ansatz didaktisch problematisch sein, da er es Lernenden häufig ermöglicht, Antworten nachzuschlagen. Durch fehlendes didaktisches Wissen und enge Zeitpläne kommt es immer wieder vor, dass die Antworten der atomistischen Aufgaben durch Durchsuchen der Instruktionen (z.B. Video oder Text) nachgeschlagen werden können. Als Folge versuchen Lernende weder ihr Wissen abzurufen, noch ihr Wissen zu organisieren und zu integrieren. Kurzum: Durch das Nachschlagen der Lösungen wird weniger gelernt. E-Learning Kurse mit einem atomistischen Ansatz können daher lernförderlich sein, aber nur, wenn die atomistischen Aufgaben, die das Assessment ausmachen, Lernende kognitiv fördern. Atomistische Ansätze eignen sicher daher gut für formale Disziplinen in denen die Lösungen von Berechnungen (z.B. Programmierung oder Mathematik) geprüft werden. Die korrekte Lösung kann in diesen Disziplinen nicht nachgeschlagen werden, sondern muss durch Aufwand der Lernenden gefunden werden.

8.3.3 Der holistische Ansatz

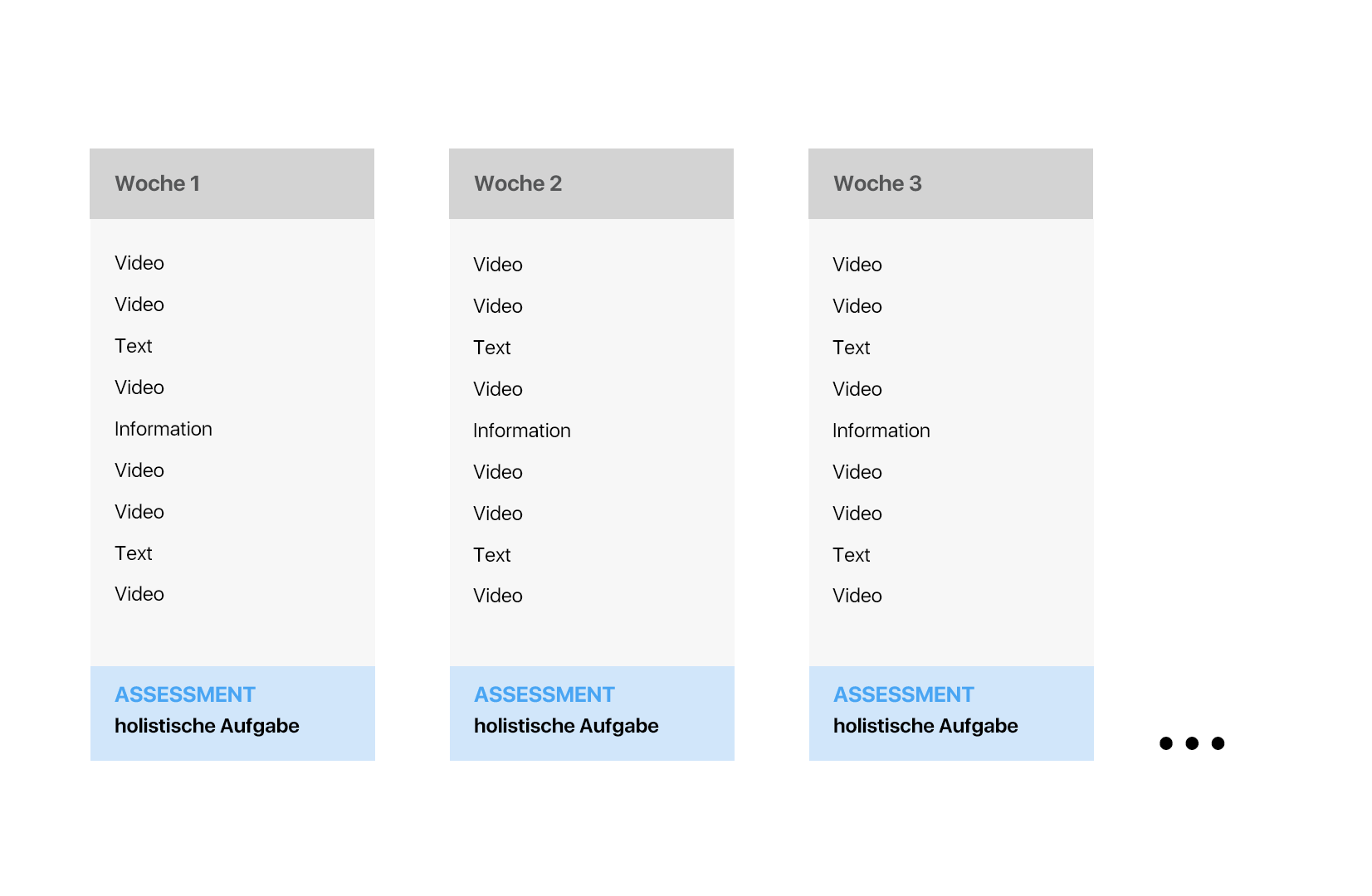

E-Learning Kurse mit dem holistischen Ansatz verlangen von Lernenden, dass sie mehrere holistische Aufgaben ausführen. Meistens werden die Lernenden in diesem Ansatz zunächst über die Inhalte der Aufgaben instruiert und anschließend erhalten die Lernenden eine holistische Aufgabe, in denen diese Inhalte angewandt werden. In der folgenden Abbildung ist ein E-Learning Kurs mit einem holistischen Ansatz dargestellt, bei dem am Ende einer jeden Woche eine holistische Aufgabe umgesetzt wird. Innerhalb der Wochen gibt es nur Formen der Instruktion, allerdings keine atomistischen Aufgaben.

Beispiel eines holistischen Ansatzes

Ein Beispiel für einen Kurs mit dem holistischen Ansatz ist das Online-Buch The Elements of Computing Systems. Nachdem Lernende lernen, wie einzelne Bausteine eines Computers aufgebaut sind, bauen die Lernenden das System durch holistische Aufgaben selber nach. Um Lernenden zu ermöglichen, einen virtuellen Computer zu bauen, erhalten sie eine begleitende Software. Ebenso hat der Kurs CS50 Introduction to Computer Science einen holistischen Ansatz. Im Kern des Kurses stehen Projekte, in denen Lernende beispielsweise ein kleines Computerprogramm oder eine Webseite schreiben. Innerhalb der einzelnen Module finden sich keine weiteren Aufgaben (weder atomistisch noch holistisch).

Kurse im holistischen Ansatz beginnen mit den holistischen Aufgaben und entwickeln auf Grundlage der Aufgaben die Instruktionen. Kurse im atomistischen Ansatz verfolgen häufig den umgekehrten Weg. Erst werden die Instruktionen konzipiert, im Anschluss werden die atomistischen Aufgaben geschrieben. Vorzugsweise sollte der erste Weg gewählt werden, da er die Lebenswelt der Lernenden ernst nimmt. Zuerst überlegt man sich, wie man das Wissen prüft, also auf Grundlage welcher Prüfungsmethode die Lernende ihr Lernen steuern werden, und überlegt sich dann wie das Wissen für die Prüfungsmethode vermittelt werden kann. Dieser Weg folgt ebenso der Idee des Constructive Alignments, da hierdurch die Lehr- und Lernaktivitäten eng mit den Prüfungsmethoden verzahnt werden.

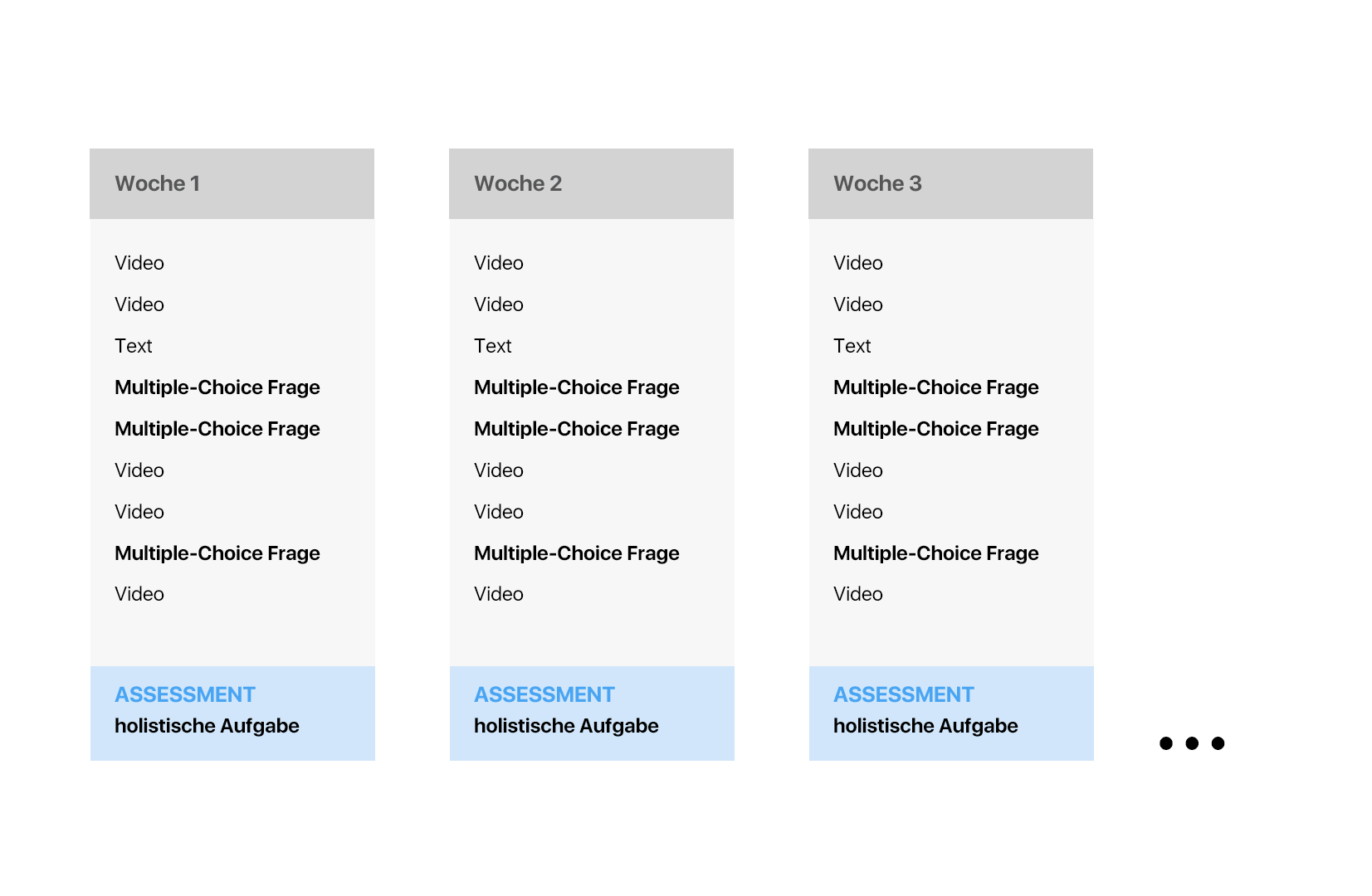

8.3.4 Der gemischte Ansatz

Der gemischte Ansatz ist eine Mischung aus dem atomistischen und dem holistischen Ansatz. Beispielsweise wird in der folgenden Abbildung ein Kurs dargestellt, in dem innerhalb der Module atomistische Aufgaben verwendet werden und am Ende der Module eine holistische Aufgabe durchgeführt werden soll:

Beispiel eines gemischten Ansatzes

Der gemischte Ansatz ermöglicht sowohl die Vermittlung einzelner Fakten und Komponenten einer komplexen Tätigkeit als auch die Vermittlung der komplexen Tätigkeit selber. Der gemischte Ansatz findet sich unter anderem im 4C/ID Modell von van Merriënboer et al. (2002). In diesem instruktionalen Designmodell sollen Lernende mehrere holistische Aufgaben durchführen. Begleitend erhalten sie zudem sogenannte Past-task practice oder Teilaufgaben. Das Ziel des 4C/ID-Modells ist die Vermittlung komplexer Fertigkeiten. Jede komplexe Fertigkeit umfasst wiederkehrende Handlungen, die automatisiert werden sollten. Eine Moderatorin sollte beispielsweise in der Lage sein, automatisch Redebeitragen zu paraphrasieren bzw. leserlich auf einer Flip-Chart zu schreiben. Der Zweck der Teilaufgaben ist es diese Automatismen zu üben. Diese Teilaufgaben sind atomistisch, da sie nur einzelne Aspekte der komplexen Handlungen üben. Sie sind aber für die komplexe Fertigkeit essentiell, da sie immer nötig sind und daher automatisiert werden sollten. Beispielsweise verfolgt der Kurs The Analytics Edge von edX diesem Modell ansatzweise. In diesem Kurs lernen Lernende verschiedene Machine-Learning-Modelle durch holistische Aufgaben anzuwenden. Die Modelle werden mit der Programmiersprache R geschrieben. Da alle Modelle in R geschrieben werden, gibt es zu Beginn des Kurses eine Fülle an atomistischen R-Aufgaben, in denen die Lernenden typische Programmierbefehle in R lernen Als Folge können sich die Lernenden bei den holistischen Aufgaben mit der Erstellung der Machine-Learning-Modelle befassen und sind nicht kognitiv damit belastet, die Modelle in R aufzuschreiben.

8.4 Der Einfluss atomistischer und holistischer Prüfungsmethode auf das Lernverhalten von Lernenden

Im Kapitel zu Constructive Alignment haben wir gesehen, dass Lernende eine starke Orientierung an den Prüfungsmethoden haben. Diese Idee findet sich in verschiedenen Formen in der Literatur weder und ist einer der wichtigsten Verhaltensweisen von Lernenden, die wir uns als E-Learning Entwickler zu Nutze machen können. Gibbs und Simpsons beispielsweise beschreiben das Lernverhalten von Lernende wie folgt: „If they drew a graph of weekly study effort for all the weeks of an individual course involving a sequence of assignments, it might look more like the Alps than like Holland." (Gibbs & Simpson, 2005, S. 14). McDowell (1995) bezeichnet dieses Verhalten auch als verstecktes Curriculum, da es zwar von den Lehrenden nicht konzipiert wird, allerdings versteckt von den Lernenden verfolgt wird. In anderen Worte: „the tail wags the dog" („der Schwanz wedelt den Hund" (van Merriënboer, 2008). Obwohl Lernende ihr Lernverhalten nicht immer auf die Prüfungsmethoden steuern möchten, erzeugt die Wahl der Prüfungsmethode einen enormen Anreiz, es dennoch zu tun. Die Prüfungsmethoden werden hierdurch das zentrale Lernziel in E-Learning Kursen. Unser Ziel als E-Learning Entwickler muss es daher sein, das Lernverhalten von Lernenden so zu steuern, dass sie tieforientiert lernen und im besten Fall, die Kenntnisse des Kurses in die Praxis transferieren können. Wir müssen uns daher fragen welche Folge die Wahl von atomistischen und holistischen Aufgaben für das Lernen in E-Learning Kursen hat.

Um heraus zu finden, inwieweit Prüfungsmethoden das Lernverhalten von Lernenden steuern, wurden meistens Fragebogenstudien durchgeführt. In diesen Studien nahmen Lernende entweder an einer realen oder fiktiven Lehrsituation teil und gaben anschließend an, ob sie oberflächlich (z.B. „When preparing for this assessment I summarised a lot of material without understanding it well.“) oder tiefergehend gelernt haben oder lernen würden („When preparing for this assessment I tried to integrate the theoretical and practical components of the course so that they had ome meaning for me”).

Zu Beginn der Beforschung dieser Frage kam man zu der Annahme, dass atomistische Prüfungsmethoden zu einem oberflächlicheren Lernverhalten führen als holistische Prüfungsmethoden. Scouller (1998) beispielsweise gab 206 Studierende in einem Kurs sowohl eine atomistische Prüfungsmethode mit Multiple-Choice Fragen als auch eine holistische Prüfungsmethode, in der Studierende ein Essay schreiben sollten. Für beide Prüfungsmethoden füllten die Studierenden mehrere Fragebögen aus, die sie nach ihrem Lernverhalten befragten (z.B. Study Process Questionnaire von Biggs). Scouller fand, dass die die Wahl von Multiple-Choice Aufgaben als Prüfungsmethode zu mehr oberflächlichen Lernstrategien führte als Essays und dass Multiple-Choice Aufgaben als kognitiv weniger anspruchsvoll wahrgenommen wurden. Interessanterweise führte eine tiefergehende Verarbeitung bei Multiple-Choice Fragen zu einem schlechterer Abschneiden als eine oberflächlichere Verarbeitung. Ebenso führte eine oberflächliche Verarbeitung bei den Essays zu einem schlechteren Abschneiden als eine tiefergehende Verarbeitung. Ähnliche Ergebnisse fanden Scouller (1996) und Rickards und Friedman (1978). Rickards und Friedmann zeigten, dass Studierende, die einen Multiple-Choice Test im Vergleich zu einem Essay als Prüfungsmethode weniger Notizen während der Vorbereitung auf den Test machten. Ebenso umfassten die Notizen bei Studierenden, die ein Essays erwarteten mehr Sätze, die zentrale Lerninhalte ansprachen. Zusammenfassend zeigten diese Studien, dass atomistische Prüfungsmethoden zu oberflächlicheren Lernstrategien führen als holistische Prüfungsmethoden.

Allerdings deutet neuere Forschung darauf hin, dass dieser Zusammenhang komplexer ist als bisher angenommen. Beispielsweise befragten Smith und Miller (2005) 248 Studierende nach ihrem Lernverhalten bei einer fiktiven Prüfungsmethode. Die Studierende gaben durch einen Fragebogen an, welches Lernverhalten sie bei einer Prüfungsmethode mit Multiple-Choice Aufgaben und einem Essay an den Tag legen würden. Ihre Ergebnisse zeigten, dass die Wahl der Prüfungsmethode keinen Einfluss auf das Lernverhalten der Lernenden haben würden. Smith und Miller erklären sich die Ergebnisse dadurch, dass das tatsächliche Lernverhalten von dem angenommen Lernverhalten abweichen könnte. Zudem könnte es sein, dass nicht die Prüfungsmethode, sondern die Wahrnehmung des Anspruchs der Prüfungsmethode ausschlaggebend für das Lernverhalten der Lernenden sein könnte. Beispielsweise könnten Studierende ein vereinfachtes Verständnis eines Essays haben und dadurch eher oberflächlichere Lernstrategien an den Tag legen. Ein erstaunlicheres Ergebnis fanden Segers et al. (2006), allerdings in einem realen Kurs. In dieser Studie verglichen Segers et al. das Lernverhalten von Lernenden in eine Kurs, in welchem atomistische Prüfungsmethoden in der Form von offenen Fragen verwendet wurden mit einem Kurs, in dem holistische Prüfungsmethoden in der Form einer problembasierten Aufgabe verwendet wurden. 406 Studierende nahmen zunächst an dem Kurs mit der atomistischen Prüfungsmethode teil. In einem weiteren Semester wurde der gleiche Kurse in einen problemorientierten Ansatz verändert. Die Ergebnisse der Studie zeigten, dass Lernende mit einem holistischen Ansatz mehr oberflächlichere Lernstrategien verwendeten als mit einem atomistischen Ansatz. Zudem zeigten die Ergebnisse, dass die Intentionen der Studierenden, ob sie oberflächliche oder tiefere Lernstrategien verwenden, am stärksten hervor sagte, welche Strategien sie tatsächlich anwenden werden. Segers et al. erklären sich dieses Ergebnis durch den Kontext, in dem der Kurs umgesetzt wurde. Studierende gaben beispielsweise an, dass der hohe Arbeitsaufwand im problembasierten Kurs sie dazu genötigt hat, eher oberflächlichere Strategien anzuwenden. Durch die geringe Zeit, holistische Aufgaben durchzuführen, werden die oberflächlicheren Lernstrategen zudem stärker gefördert. Segers et al. (2006) betonen daher, dass das Lernverhalten von Lernenden weniger durch die Wahl der Prüfungsmethode, sondern die Intention der Lernenden gesteuert wird. Sie schlagen vor, dass Lehrende stärker die Prüfungsmethode und die Erwartungen an die Prüfungsmethoden vorstellen und diskutieren sollten (siehe auch Black und Wiliam, 1998), um das Verhalten der Lernenden positiv zu beeinflussen. Diese Annahme konnten Segers et al. (2008a) bestätigen. In ihrer Studie befragten sie 110 Studierende nach ihrem Lernverhalten in einem projektorientierten Kurs. Lernende, die tiefergehende Lernstrategien anwendeten, schnitten besser bei den Portfolioaufgaben ab als Lernende, die oberflächlichere Strategien verwendeten. Ebenso zeigten die Ergebnisse, dass die Projekte umso besser umgesetzt werden, je stärker Studierende Feedback auf ihre Projekte annahmen. Je stärker zudem das Feedback angenommen wurde, desto mehr tiefergehende Lernstrategien wurden verwendet. Die Ergebnisse deuten daher darauf hin, dass der Kontext in dem holistische Aufgaben umgesetzt werden, einen wichtigen Einfluss auf das Lernverhalten der Lernenden hat. Wir werden später nochmal auf diese Idee zu sprechen kommen, wenn wir uns mit Bewertungsschemas beschäftigen. In einer ähnlichen Studie untersuchten Segers et al. (2008b) das Lernverhalten von Lernenden in einem Kurs, in denen die Prüfungsmethode holistische Aufgaben in Form von Fallanalysen waren. Die Studie wurde mit angehenden Lehrkräften in ihrem dritten Jahr an der Universität durchgeführt. Korrelationsanalysen ergaben, dass je tiefergehend Studierende die Prüfungsmethode einstuften, desto weniger oberflächlichere Strategien verwendeten wurden. Allerdings zeigten die Ergebnisse auch, dass Lernende die zwar annehmen, dass eine Prüfungsmethode oberflächliche Strategien verlangen, dennoch tiefere Lernstrategien anwenden.

Was machen wir aus diesen Ergebnissen? Zunächst zeigen die Studien, dass atomistische Prüfungsmethoden nicht zwingend zu oberflächlichen Lernstrategien führen. Weiterhin zeigen die Studien, dass die Wahrnehmung der Lernenden über die Anspruch der Prüfungsmethoden darüber entscheidet, welches Lernverhalten sie an den Tag legen. Es wäre daher falsch zu sagen, der atomistische Ansatz sollte nicht in E-Learning Kursen verwendet werden. Allerdings deuten die Ergebnisse in der Tendenz darauf hin, dass atomistische Prüfungsmethoden ein oberflächlicheres Lernverhalten fördern als holistische Prüfungsmethoden. Entscheidend ist, inwieweit E-Learning Entwickler in der Lage sind, die Ansprüche an die Prüfungsmethoden an die Lernenden zu kommunizieren. Hierfür eignen sich insbesondere ausführliche Bewertungsschemas, auf die wir gleich eingehen werden. Zuvor überlegen wir uns allerdings, wie Multiple-Choice Aufgaben, als Prototyp der atomistischen Aufgaben, gestaltet werden sollten.

8.5 Der Prototyp des atomistischen Ansatzes: Multiple-Choice Aufgaben

Du wirst kaum einen E-Learning Kurs ohne Multiple-Choice Aufgaben finden. Multiple-Choice ist die gängigste und etablierteste Form der Übungs- und Prüfungsmethoden (Gierl et al., 2017). Ein Vorteil von Multiple-Choice Aufgaben ist, dass sie es erlauben, die Lerninhalte flächendeckend abzufragen. Dadurch, dass sie die Breite der Lerninhalte abfragen, erschweren sie gleichzeitig die Lerninhalte in der Tiefe zu lernen (Gardner, 1993). Garder bezeichnet Prüfungsmethoden wie Multiple-Choice Aufgaben abfragen daher auch als „Feinde des Verständnisses". Nichtsdestotrotz sind Multiple-Choice Aufgaben beliebt. Wir sollten daher umfassend verstehen, wie lernförderliche Multiple-Choice Aufgaben verfasst werden.

8.5.1 Typen an Multiple-Choice Aufgaben

Zunächst haben alle Multiple-Choice Fragen die gleiche Form. Die eigentliche Frage wird als Stamm bezeichnet und die Antwortmöglichkeiten als Items. Lernende lesen zunächst den Stamm und müssen dann eine der verschiedenen Items auswählen. Allerdings gibt es verschiedene Typen an Multiple-Choice Aufgaben. Zwei Taxonomien für die Einteilung dieser Typen wurden von Aiken (1982) und Haladyna et al. (2002) vorgeschlagen. Aiken unterteilt fünf Typen an Multiple-Choice Fragen:

- Typ 1: Der erste Typ umfasst eine Aussage (p für premise) und eine Reihe an Items, welche eine Konsequenz beschreiben (c für consequence): p -> c. In anderen Worten folgt der erste Typ einer Wenn-Dann-Beziehung. Zum Beispiel: „Sollte die Erderwärmung weiter voran schreiten, (a) wird der Meeresspiegel steigen, (b) wird die mittlere Temperatur der Erde sinken, (c) vergrößert sich die Ozone-Schicht.“. Der erste Typ umfasst zudem Fragen, zu denen eine Antwort gegeben werden sollte. Dies ist die häufigste Form an Multiple-Choice Fragen: „Wer ist der aktuelle Präsident der Vereinigten Staaten? (a) Joe Biden, (b) Barack Obama, (c) Donald Trump.”

- Typ 2: Beim zweiten Typ umfasst der Stamm der Frage zwei oder mehr Aussagen und die Items einer Antwort, die aufgrund der beiden Aussagen getroffen werden kann. Zum Beispiel: „Der erste Freiheitsgrad einer F-Verteilung ist 3, der zweite Freiheitsgrad 7. Wie lautet der F-Wert? (a) 4.34, (b) 5.83, (c), 2.18"

- Typ 3: Der dritte Typ ist eine Klassifikationsaufgabe, bei zu einer Aussage eine Wort ergänzt werden soll. Zum Beispiel: „Jean Piaget kann am besten als ein _______ charakterisiert werden. (a) Entwicklungspsychologe, (b) Psychologe, (c) Sozialforscher". Dieser Typ ist sozusagen ein eine Lückenaufgabe mit einer Auswahl.

- Typ 4: Der vierte Typ zeichnet sich dadurch aus Lernende aus mehreren Aussagen die richtigen finden sollen. Zum Beispiel: „(1) Barack Obama war der erste schwarze Präsident der vereinigten Staaten. (2) Er ist außerhalb der USA geboren. (a) 1 und 2 sind korrekt, (b) 1, aber nicht 2 ist korrekt, (c) 2, aber nicht 1 ist korrekt, (d) weder 1 noch 2 ist korrekt". Dieser Typ ist nichts anderes als eine Kombination mehrerer Wahr-Falsch-Aussagen. Die Schwierigkeit und die Länge dieses Typs steigt exponentiell mit der Anzahl der Aussagen. Bei vier Aussagen, hätte man bereits 16 Kombinationsmöglichkeiten.

- Typ 5: Der fünfte Typ erfragt Lernende nach der analogen Beziehung zwischen zwei Konzepten. Zum Beispiel: „Die Standardabweichung einer Stichprobenverteilung ist wie der ____ zur Stichprobenkennwertverteilung. (a) Standardfehler, (b) Median, (c) t-Verteilung.

Eine weitere Taxonomie stammt von Haladyna et al. (2002). Sie unterscheiden sieben Typen an Multiple-Choice Fragen.

- Der erste Typ (Conventional Choice) ist mit dem Typ 1 nach Aiken (1982) gleichzusetzen. Der Stamm der Multiple-Choice Frage umfasst eine Aussage oder eine Frage, die Items umfassen eine Konsequenz oder eine Antwortmöglichkeit auf die Frage.

- Der zweite Typ (Alternate-Choice) ist eine besondere Form des ersten Typs, mit allerdings nur zwei Antwortoptionen. Zum Beispiel: „Welche der folgenden Szenarien verringert den Respirationsprozess von Pflanzen am stärksten? (a) kaltes Wetter, (b) warmes Wetter."

- Der dritte Typ (True-False) ist bei Aiken (1982) nicht aufgeführt und beschreibt eine Aussage, die nach wahr oder falsch bewertet werden soll. Zum Beispiel: „Berlin ist die Hauptstadt von Deutschland. (a) korrekt, (b) inkorrekt". Streng genommen kann dieser dritte Typ mit dem Typ 1 nach Aiken (1982) gleichgesetzt werden, allerdings erwähnt Aiken Wahr- bzw. Falschaussagen in seiner Taxonomie nicht. Ebenso ist der dritte Type eine Mischung aus dem ersten und dem zweiten Typ.

- Der vierte Typ (Multiple True-False) verlangt von Lernenden, dass sie auf Grundlage einer oder mehrerer Aussagen im Stamm mehrere Items mit richtig oder falsch benennen. Zum Beispiel: „Du führst eine Moderation durch. Welche der folgenden Verhaltensweisen ist konform zur Rolle eines Moderators oder einer Moderatorin (Notiere ein A hinter das Item für korrekt, B für inkorrekt)? (a) Du bringst deine eigene Meinung in die Diskussion ein. (b) Du versuchst alle Teilnehmenden zu Wort kommen zu lassen. (c) Du hast vor dem Treffen eine Idee über den Ausgang der Moderation und versuchst die Teilnehmer von diesem Ausgang zu überzeugen." Dieser Typ ist ähnlich zu Typ 4 von Aiken, wenngleich Aiken die Antwortmöglichkeiten in den Stamm stellt.

- Der fünfte Typ (Matching) verlangt von Lernenden, dass sie zwei Listen an Wörter zueinander ordnen. Beispielsweise wird dieser Typ in Sprachkursen häufig verwendet, in denen Wörter von der einen Sprache in die andere Sprache übersetzt werden sollen. Auf der linken Spalte würden die Worte in der Muttersprache, auf der rechten Spalte die Wörter in der Zielsprache stehen.

- Die sechste Typ (Complex MC) ist Deckungsgleich mit dem Typ 4 von Aiken (1982). Mehrere Aussagen werden getroffen und für jede Aussage muss entschieden werden, ob sie korrekt oder inkorrekt ist. Zum Beispiel: „Welche der folgenden Pflanzen sind Früchte? (1) Tomaten, (2) Tomatillos, (3) Habenero Chilschoten? (a) 1 und 2, (b) 2 und 3, (c) 1 und 3, (d) 1, 2 und 3.

- Der siebte Typ (Context-Dependent Item Set) ist eine Erweiterung des ersten Typs, nur dass mehrere Multiple-Choice Fragen zu einem spezifischen Kontext gewählt werden. Beispielsweise, indem sich Lernende vorstellen, sollen, sie führen eine bestimmte Studie durch und ihnen anschließend mehrere Multiple-Choice Fragen zu dieser Studie gestellt werden.

Haldyna et al. (2002) haben in ihrem Artikel untersucht, wie häufig diese sieben Typen in Lehrbüchern über Multiple-Choice Fragen besprochen werden. Conventional-MC und Matching Aufgaben wurden in jedem dieser Lehrbücher besprochen. In 70% der Bücher wurden Context-Dependent Items Sets verwendet. Alles in allem zeigt sich, dass es eine hohe Variabilität in der Formulierung von Multiple-Choice Fragen gibt. In der Praxis wird allerdings nur eine geringe Anzahl dieser Fragen umgesetzt.

8.5.2 Lernförderliche Konstruktion von Multiple-Choice Aufgaben

Sofern wir Multiple-Choice Fragen als formatives Assessment sehen, müssen wir uns überlegen, wie sie eingesetzt werden können, um Lernen zu fördern. Multiple-Choice Fragen fördern zunächst zwei Funktionen. Zum einem zwingen sie Lernende ihr Wissen zu veräußern und sind somit bereits eine Lerngelegenheit (McDaniel et al., 2007; Roediger & Karpicke, 2006). Zum anderen können wir Lernende auf Grundlage der Antwort zu den Multiple-Choice Aufgaben Feedback über Ihre Leistung erhalten. Im Modell von Black und Wiliam (2009) erfüllen Multiple-Choice Fragen daher das zweite und dritte Kriterium. Allerdings ist die Beantwortung von Multiple-Choice Aufgaben nur lernförderlich, sofern Lernende über die Antworten nachdenken. Das klingt simpel, allerdings haben Lernende eine Fülle an Strategien, um kognitiven Aufwand bei der Beantwortung der Multiple-Choice Fragen zu vermeiden. Biggs (2007, S. 203) beispielsweise beschreibt folgende beliebten Strategien von Lernenden.

- Gibt es vier Antwortmöglichkeiten in einer Multiple-Choice Frage, schließe die Antwortmöglichkeit mit den meisten technischen Fachbegriffen aus.

- Durch eliminieren der offensichtlich falschen Antwortmöglichkeiten reduziere ich die Chance auf eine richtige Antwort häufig auf 50%.

- Längere Antworten sind meistens ein Indikator für eine richtige Antwort.

- Eine Möglichkeit erwähnt Biggs nicht: Die Frage klingt bekannt: Ich schaue einfach nochmal in den Unterlagen, ob dort die Antwort steht.

Nicht jeder dieser Strategien ist immer erfolgreich und nicht jede dieser Strategien wird von allen Lernenden angewandt. Allerdings verleiten Multiple-Choice Fragen zu solchen Strategien und haben als Folge, dass Lernende anstatt über den Lerninhalt nachdenken, über Strategien zur Beantwortung der Fragen nachdenken. Selbst wenn Multiple-Choice Fragen daher praktisch tiefere Lernstrategien ansprechen könnten, verleiten sie nur selten zu diesen tieferen Lernstrategien.

Wir können die Lernstrategien von Lernenden daher nicht erzwingen, allerdings Multiple-Choice Aufgaben so gestalten, dass sie sowohl für Lehrende einfach zu konzipieren sind und für Lernende eindeutig und verständlich sind. Für die lernförderliche Gestaltung von Multiple-Choice Aufgaben wurden daher eine Reihe an Leitfäden erstellt. Haladyna et al. (2002) haben diese Leitfaden in einem ausführlichen Review zusammen getragen. In diesem Review haben die Autoren versucht die häufigsten und am besten untersuchtesten Gestaltungsrichtlinien aus 27 Leitfäden und 32 Gestaltungsrichtlinien zu synthetisieren. Zunächst empfehlen Haladyna et al. (2002), das Multiple-Choice Aufgaben eine einfache Sprache verwenden sollten. Multiple-Choice Fragen prüfen den Lerninhalt, nicht die Sprachgewandtheit der Lernenden. Eine komplexe Sprache schafft daher für Lernende einen Nachteil, die über weniger Sprachvermögen verfügen. Als Folge testen die Multiple-Choice Fragen nicht nur den Lerninhalt, sondern auch die Sprachfertigkeiten. Dies sollte man vermeiden. Multiple-Choice Items sollten zudem vertikal und nicht horizontal angeordnet werden. Diese Empfehlung beruht auf einer Konvention. Lernende die Items in der vertikalen Konvention erhalten, wissen sofort, wie sie die Fragen zu beantworten haben und müssen sich nicht überlegen, ob sie die Beantwortung korrekt verstehen. Weiterhin sollte die zentrale Frage, die zentrale Aussage der Multiple-Choice Frage im Stamm zu finden sein. Falsch wäre zum Beispiel: „Validität. (a) Bezieht sich auf Tests und nicht Testwerte, (b) ist genauso wichtig wie die Reliabilität, (c) …“. Erneut ist es eine gängige Konvention die zentrale Aussage in den Stamm zu bringen. Dies vereinfacht die Interpretation der Frage. Zudem sollten die Aussagen im Stamm positiv und nicht negativ formuliert werden. Anstatt zu sagen „Welches dieser Tiere ist kein Säugetier?” sollte man fragen „Welches dieser Tiere ist ein Reptil?“. Die Negierung des Stamms verkompliziert den Stamm unnötigerweise. Eine weitere Empfehlung von Haladyna et al. (2002) ist so viele plausible Distraktoren wie möglich zu benutzen. Diese Empfehlung erlaubt eine hohen Interpretationsspielraum, allerdings hilft die Empfehlung, nicht zu viele Distraktoren zu verwenden. Konkreter wird Rodriguez (2005) in seiner Studie. Auf Grundlage einer ausführlichen Synthese der bisherigen Forschung empfiehlt er in etwa drei Antwortmöglichkeiten. Aus statistischen Gründen ist es selten von Vorteil mehr Items zu verwenden. Ebenso sind drei Items höchst ökonomisch und können schneller erstellt werden. Eine Reduzierung der Items von fünf auf drei beispielsweise verringert die Itemschwierigkeit lediglich um 7% und macht keinen Unterschied auf die Unterscheidungsfähigkeit als auch die Reliabilität der Items. Eine weitere wichtige Empfehlung von Haladyna et al. ist die grammatikalische und inhaltliche Struktur der Antwortmöglichkeiten homogen zu halten. Als Folge müssen sich Lernende stärker auf den Inhalt der Frage konzentrieren und die Frage nicht semantisch oder grammatikalisch entschlüsseln. Letzteres ist erneut kein Zweck von Multiple-Choice Fragen. Zuletzt sollten man auf Antwortmöglichkeiten wie „keine der Antwortmöglichkeiten” oder „alle Antwortmöglichkeiten" verzichten.

Eine weitere Empfehlung wurde von Gier et al. (2017) vorgeschlagen. Sie untersuchten in ihrem Review wie Distraktoren in Multiple-Choice Fragen gestaltet werden sollten. Unter anderem empfehlen sie, dass die Distraktoren gängige Misskonzepte von Lernenden ansprechen sollten. Wie erfährt man diese Misskonzepte? Am einfachsten, indem man sich bei der Konstruktion der Multiple-Choice Fragen überlegt, was Lernende Antworten würden, hätten sie nur den Stamm zur Verfügung. Um dieses Kriterium zu erfüllen, braucht man Erfahrungswissen beziehungsweise ein Verständnis über das Vorwissen der Lernenden. Ein weiteres wichtiges Kriterium ist, dass die Antwortmöglichkeiten unabhängig voneinander sein sollten. Für folgende Frage ist dieses Kriterium beispielsweise nicht erfüllt: „Wo befindet sich Ulm? (a) in Schwaben, (b) in Baden-Württemberg, (c) im Saarland". Ulm befindet sich allerdings sowohl in Schwaben als auch in Baden-Württemberg. Zudem ist Baden-Württemberg teils schwäbisch. Die Items sind daher nicht unabhängig voneinander. Beachtet man dieses Prinzip nicht, gibt es hierdurch keine eindeutigen Antworten und Lernende sind bei der Beantwortung der Frage verwirrt.

Haldyna et al. (2002) betonen explizit, dass diese Empfehlungen noch nicht auf einem festen wissenschaftlichen Fundament stehen: „The science of MC item writing is advancing, but item writing is still largely a create act that we inexorably link to content standards and instruction" (S. 329). Viele dieser Empfehlungen beruhen daher auf Erfahrungswerten und werden teils durch empirische Forschung unterstützt.

8.5.3 Lernrelevante Besonderheiten von Multiple-Choice Aufgaben

Selbst wenn Multiple-Choice Fragen alle wichtigen Kriterien erfüllen, haben sie dennoch ein paar wichtige lernrelevante Besonderheiten. Wir hatten bereits erwähnt, dass die Beantwortung von Multiple-Choice Fragen lernförderlich ist, da sie den bekannten Testing-Effekt fördern, der besagt, dass der Abruf von Wissen selbst eine Lerngelegenheit darstellt. Dieser Effekt konnte in einigen Studien mit Multiple-Choice Fragen gefunden werden (Roediger & Marsh, 2005; Marsh et al., 2007; Little et al., 2012). Roediger und Marsh (2005) beispielsweise fanden einen großen positiven Lerneffekt für Multiple-Choice Fragen. Eine größere Anzahl an Multiple-Choice Fragen führte in der Studie zu einer höheren Erinnerungsleistung für Fakten als keine oder wenige Multiple-Choice Fragen.

Allerdings haben Multiple-Choice Fragen ebenso einen Nebeneffekt. Jede Multiple-Choice Frage enthält mehrere falsche Antworten. Selbst wenn Lernende die korrekte Antwort ankreuzen, verarbeiten sie diese falschen Antworten. Da der Abruf von Wissen bereits eine Lerngelegenheit darstellt und Lernende die falschen Antworten verarbeiten, könnte es sein, dass sich Lernende die falschen Antworten einprägen. Roediger und Marsh beispielsweise fanden, dass inkorrekte Antworten bei einem Multiple-Choice Tests dazu führte, dass Studierende in einem späteren Test wahrscheinlicher diese falschen Antworten erneut ankreuzten. Der Effekt war stärker, je mehr Antwortalternativen es gab. Dieser Befund deutet erneut darauf hin, dass Multiple-Choice Aufgaben nur eine begrenzte Anzahl an Distraktoren erhalten sollten. Marsh et al. (2007) zeigten allerdings, dass der Effekt nicht für Antworten gilt, die korrekt beantwortet werden. Ebenso wechselten die Lernenden die falschen Antworten nicht zwischen zwei Multiple-Choice Tests (erst A, dann B). Der Effekt trat nur für die gleiche falsche Antwortmöglichkeit auf. In einer weiteren Studie untersuchten Huelser und Marsh (2006) unter welchen Bedingungen die inkorrekten Antworten gemerkt werden. Hierzu ließen sie die Lernenden nach jeder Multiple-Choice Frage erklären, weshalb sie eine bestimmte Antwort wählten. Es zeigte sich, dass falsche Antworten eher erinnert werden, wenn sie das Resultat eines Denkprozesses der Lernenden sind. Wenn Lernende die Antwort raten, hatte dies keinen Einfluss auf die falsche Erinnerung. Dieses Ergebnis bekräftigt erneut die Wichtigkeit von formativen Feedback. Lernende benötigen eine Rückmeldung über ihre Leistung, um Misskonzepte und falsche Erinnerung zu korrigieren.

In Anbetracht der Tatsache, dass sich Lernende durch die falsche Beantwortung von Multiple-Choice Fragen „falsches" Wissen aneignen können, sollten wir uns als E-Learning Entwickler überlegen, wie wir das Assessment so gestalten können, dass es den größten Mehrwert für die Lernenden darstellt. Zu Beginn dieses Kapitels haben wir bereits ausführlich über das formative Asssessment-Modell von Black und Wiliam (2009) gesprochen. Um dieses wirksam in E-Learning Kurse einzubinden, müssen wir am Ende dieses Kapitels die Rolle von Bewertungsschema verstehen.

8.6 Bewertungsschema für holistische Aufgaben

Stell dir eine Lernende in einem E-Learning Kurs mit einem atomistischen Ansatz vor. Die Lernende schaut sich ein die Videos des Kurses an und beantwortet nach jedem Modul einen Multiple-Choice Test. Am Ende des Kurses erreicht sie 80% der gesamten Punkte. Ihr ist das Zertifikat wichtig, deswegen hat sie versucht, die Fragen möglichst korrekt, aber auch schnell zu beantworten. Ebenso hat sie festgestellt, dass sie sich erst die Testaufgaben ansehen und sich erst dann die passenden Videos dazu ansehen kann. Diese Lernende wird sicherlich einige Qualifikationen aus dem Kurs mitnehmen. Der Aufbau des Kurses sorgt allerdings dafür, dass sie einzelne Wissensinseln lernen wird, ohne jedoch nachhaltig eine Fertigkeit zu lernen.

Stell dir nun eine Lernende in einem anderen E-Learning Kurs mit einem holistischen oder gemischten Ansatz vor. Die Lernende schaut sich erneut alle Videos an und muss nach jedem Modul eine holistische Aufgabe lösen. Bevor sie diese Aufgabe löst, erhält sie allerdings ein ausführliches Bewertungsschema, in welchem ihr erklärt wird, wodurch sich eine schlechte von einer guten Abgabe unterscheidet. Aus dem Bewertungsschema lernt sie, auf welche Kriterien bei der holistischen Aufgabe geachtet wird und sieht, was für eine sehr gute Abgabe verlangt wird. Sie versucht ihre Aufgabe nach diesen Kriterien umzusetzen. Nachdem sie die Aufgabe abgegeben hat, erhält sie zudem Feedback von einer Lehrperson. Die Lehrperson beschreibt in diesem Feedback, wie gut sie in jedem Kriterium war und gibt ihr kurze Rückmeldungen in Form eines Textes, wie sie sich weiter verbessern kann. Die Aufgabe ist erst erfolgreich abgeschlossen, sobald sie alle Kriterien mindestens gut umgesetzt hat.

Worin unterscheiden sich diesen beiden Kurse voneinander? Der wichtigste Unterschied ist, dass der zweite Kurs das formative Assessmentmodell von Black und Wiliam (2009) konsequent umsetzt. Das erste Kriterium von Black und Wiliam (2009) beispielsweise besagt, dass Lernende über die Ziele und die Kriterien für das Erreichen der Ziele informiert sein sollten. Durch das Bewertungsschema weiß die Lernende genau, was von ihr verlangt wird. Des Weiteren erhält die Lernende im zweiten Kurs Feedback über ihre Leistung, im ersten Kurs nicht. Damit erfüllt der zweite Kurs das dritte Kriterium nach Black und Wiliam (2009). Zudem ist das fünfte Kriterium im zweiten Kurs umgesetzt, indem Lernende angeregt werden, sich aktiv an ihrem Lernen zu beteiligen. Die Lernende muss sich im zweiten Kurs stetig verbessern, um die holistische Aufgabe erfolgreich abzuschließen. Im ersten Kurs kann die Lernende auch mit ein paar Tricks das Zertifikat erhalten.

Bewertungsschema eigenen sich deswegen außerordentlich gut, da sie sowohl ein Kommunikationsinstrument für die Erwartungshaltungen an einen E-Learning Kurs sind, die Perspektive der Lehrenden an dem Assessment ernst nehmen, eine diagnostische Funktion haben und Feedback ermöglichen. Ebenso ermöglichen Bewertungsschema den Austausch zwischen Lehrpersonen, Peers und Lernenden in einem E-Learning Kurs und haben dadurch eine soziale Funktion. Im Sinne des Constructive Alignments schaffen Bewertungsschema zudem eine Brücke zwischen den intendierten Lernzielen und den Prüfungsmethoden. Sowohl für die Lernenden und die Lehrenden wird die Verbindung direkt ersichtlich, da sie in Form des Bewertungsschema verschriftlicht ist. Zudem ermöglicht ein ausformuliertes Bewertungsschema Lehrende, sinnvolle Lehr- und Lernmethoden auszuwählen, die die Lernenden auf die holistischen Aufgaben vorbereiten.

Alle diese Funktionen werden in kaum einem E-Learning Kurs erreicht. Der Aufwand wäre hierfür zu groß. Beispielsweise war es in Oxford oder Cambridge früher üblich, dass Lernende jede Woche Essays schreiben und diese mit einem Tutor ausführlich besprachen (Gibbs & Simpsons, 2005). Wie aufwändig diese Art der Bewertung ist zeigt sich auch an verschiedenen Open Universities. Unter anderem stellen manche Open Universities, in denen Studierende ihren Abschluss ausschließlich online erhalten, über 7500 Tutoren ein, um Studierenden Feedback zu geben. Udacity wiederum stellt Tausende Mentoren ein, die auf Grundlage von Bewertungsschema Lernenden Rückmeldung über ihre Leistung geben. Meistens bereits nach weniger als 12 Stunden. Dennoch, Bewertungsschema eignen sich für E-Learning Kurse hervorragend und ermöglichen die Umsetzung des formativen Feedbacks und des Constructive Alignments.

8.6.1 Aufbau eines Bewertungsschema

Bewertungsschema sind immer nach dem gleichen Prinzip aufgebaut. Sie enthalten mehrere Kriterien, welche geprüft werden und mehrere Levels, die qualitative Unterschiede in der Umsetzung der Kriterien anzeigen:

| Level 1 | Level 2 | Level 3 | |

|---|---|---|---|

| Kriterium 1 | |||

| Kriterium 2 | |||

| Kriterium 3 |

Schau dir beispielsweise diese Bewertungsschema von Udacity an. In dem Projekt How to Use Git and GitHub erhalten Lernende drei Bewertungsschema. Jedes Bewertungsschema hat drei Levels: Does Not Meet Specification, Meets Specification, Exceeds Specifications. Für jedes Level eines jeden Kriteriums ist anhand eines Textes aufgeführt, was für das jeweilige Level des Kriteriums von den Lernenden verlangt wird. Sobald Lernende das Projekt einschicken, erhalten sie von den Mentoren für jedes Kriterium das erreichte Level und einen kurzen Text, der auf ihre Leistung eingeht und ihnen sagt, wie sie von diesem Stand weiter lernen sollten.

Es gibt verschiedene Varianten der Levels. Es sollten nur nicht mehr als fünf gewählt werden, ansonsten sind diese nicht mehr unterscheidbar (siehe Biggs, 2007). Unter anderem sind folgende Levels beliebt (siehe Stevens & Levi, 2013, S. 8):

- Sophisticated, competent, partly competent, not yet competent

- Exemplary, proficient, marginal, unacceptable

- Advanced, intermediate high, high, novice

- Distinguished, proficient, intermediate, novice

- Accomplished, average, developing, beginning

Ein weiteres Beispiel für ein Bewertungsschema stammt von Wyss et al. (2014). In ihrem Artikel stellen sie ein Bewertungsschema für Online-Diskussionen in E-Learning Kursen vor. Das Bewertungsschema sieht in etwas folgendermaßen aus: